FluxMusic 是一个创新的开源音乐生成模型,利用扩散模型和 Transformer 架构,将文本描述转化为音乐作品。此模型能够处理复杂的文本输入,生成符合特定情感、风格和乐器的音乐,适合各种硬件需求。

FluxMusic是什么

FluxMusic 是一个开源的音乐生成工具,基于先进的扩散模型和 Transformer 框架,将用户提供的文本描述转化为音乐。它能够处理复杂的指令,生成具有特定情感、风格和乐器的音乐。FluxMusic 具有不同规模的模型选择,从小型到大型,满足不同硬件的需求。使用了修正流技术,进一步提升了音乐的自然度和质量,所有相关的代码和模型权重均可在 GitHub 上获取。

FluxMusic的主要功能

- 文本到音乐生成:用户可以通过输入文本描述,直接生成音乐,充分发挥创意。

- 语义理解:借助预训练的文本编码器,捕捉文本中的语义信息,确保生成的音乐与描述的情感与风格相一致。

- 多模态融合:结合文本和音乐模态,通过深度学习技术,深入理解文本与音乐之间的关系,实现精准的音乐生成。

- 高效的训练策略:采用修正流的训练方法,提升模型训练效率,确保生成音乐的高质量。

- 可扩展性:模型架构设计灵活,通过调整参数和配置,适应不同规模和需求的音乐生成任务。

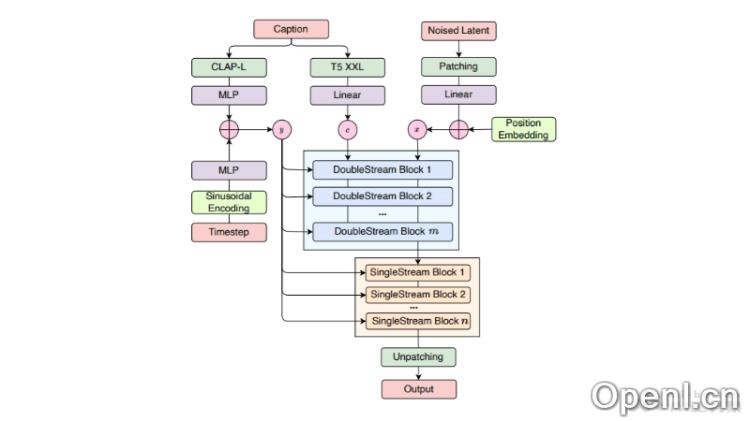

FluxMusic的技术原理

- 扩散模型(Diffusion Models):模拟数据从有序状态逐渐转变为随机噪声的过程,并逆转这一过程,以生成新的音乐样本。

- 修正流变换器(Rectified Flow Transformers):通过定义数据与噪声之间的线性轨迹,优化生成过程,提高音乐的真实感和自然度。

- 双流注意力机制(Dual-stream Attention Mechanism):处理文本与音乐的联合序列,实现信息的双向流动,使模型同时考虑文本内容和音乐特征。

- 堆叠单流块(Stacked Single-stream Blocks):在文本流被丢弃后,专注于音乐序列的建模和噪声预测,进一步提升音乐生成的准确性。

- 预训练文本编码器(Pre-trained Text Encoders):基于如 T5 XXL 和 CLAP-L 等预训练模型,提取文本特征,增强对文本描述的理解能力。

FluxMusic的项目地址

- GitHub仓库:https://github.com/feizc/FluxMusic

- HuggingFace模型库:https://huggingface.co/feizhengcong/FluxMusic

- arXiv技术论文:https://arxiv.org/pdf/2409.00587

FluxMusic的应用场景

- 音乐创作辅助:音乐家和作曲家可以借助 FluxMusic 作为灵感来源,迅速生成音乐草稿,加速创作过程。

- 影视配乐:在电影、电视剧、广告及视频游戏制作中,FluxMusic 能根据剧本或场景描述自动生成配乐,提升音乐制作效率。

- 游戏音乐生成:在电子游戏中,FluxMusic 可以根据游戏情境及玩家行为实时生成背景音乐,增强游戏体验。

- 音乐教育:作为教学工具,FluxMusic 帮助学生理解音乐创作过程,通过实践学习音乐理论与作曲技巧。

- 个性化音乐体验:普通用户可以通过输入自己的情感状态、场景描述或故事,生成独特的个性化音乐,创造独特的听觉体验。

常见问题

- FluxMusic支持哪些文本格式?:FluxMusic支持多种文本格式,用户可以通过详细描述、关键词或短语来生成音乐。

- 我需要什么样的硬件来运行FluxMusic?:FluxMusic提供了不同规模的模型,用户可以根据自己的硬件配置选择适合的版本。

- 生成的音乐可以用作商业用途吗?:生成的音乐作品遵循开源协议,用户需要查看具体的使用条款。

- 如何获取FluxMusic的最新更新?:用户可以关注FluxMusic的GitHub仓库,以获取最新的更新和发布信息。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号