GameGen-O 是腾讯推出的一款基于 Transformer 架构的创新游戏视频生成模型,旨在为开放世界视频游戏的开发提供强大的支持。这个模型能够模拟游戏引擎的多种功能,包括角色生成、动态环境创建和复杂动作模拟,用户可以通过文本指令、操作信号和视频提示与游戏内容进行交互控制。GameGen-O 的发布将对游戏开发行业带来深远的影响,降低开发成本和时间,同时为玩家带来更多的创作自由。

GameGen-O是什么

GameGen-O 是腾讯开发的一款基于 Transformer 架构的游戏视频生成模型,特别适用于开放世界视频游戏的创作。该模型能够模拟游戏引擎的多种功能,生成游戏角色、动态环境和复杂动作,并且支持用户通过文本、操作信号和视频提示来控制游戏内容。GameGen-O 的开发过程涉及大量数据的收集与处理,创建了首个开放世界视频游戏数据集(OGameData),并经历了基础模型预训练和指令调整两个阶段。这一模型的推出将对游戏开发行业产生积极影响,能够显著降低开发成本和时间,并为玩家提供更大的创造空间。

GameGen-O的主要功能

- 角色生成:根据用户的文本指令,生成多种类型的角色,如西部牛仔、宇航员和魔法师等。

- 环境生成:创造动态的游戏环境,适应不同的游戏风格和场景需求。

- 动作生成:支持生成复杂的角色动作,包括驾驶、飞行和射击等。

- 事件生成:能够生成游戏中的各种事件,例如天气变化和自然灾害等。

- 交互控制:用户可以通过文本、操作信号和视频提示与游戏内容进行交互,提升游戏的互动体验。

GameGen-O的技术原理

- 开放域生成:GameGen-O 能够生成各种类型的游戏元素,包括角色、环境、动作和事件,极大地扩展了游戏设计的可能性。

- 交互式可控性:模型支持通过 InstructNet 分支进行交互式控制,使用户能够调整角色行为、环境布局和事件触发等。

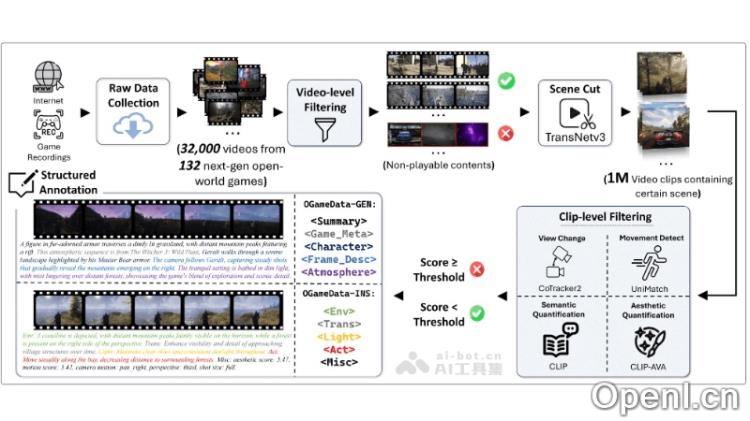

- OGameData 数据集:为了训练 GameGen-O,团队构建了大规模的开放世界电子游戏数据集 OGameData,涵盖来自150多个游戏的4000多个小时的视频片段,涉及多种游戏类型和风格。

- 两阶段训练:模型采用了基础模型预训练和指令微调的两阶段训练策略,确保生成高质量的游戏视频并具备根据用户指令生成内容的能力。

- 技术创新:GameGen-O 采用了多种先进技术,如2+1D VAE视频压缩、混合训练策略和掩码注意力机制,保证模型的稳定性和生成质量。

- 数据集构建和训练过程:团队从互联网上收集了32,000个原始视频,经过专家筛选和GPT-4o标注,形成高质量的训练数据。基础训练阶段使用变分自编码器对视频片段进行压缩,采用不同的帧速率和分辨率的混合训练策略。

- InstructNet:在微调阶段,使用可训练的 InstructNet 接受多模态输入,包括文本、操作信号和视频提示,实现对生成内容的灵活控制。

GameGen-O的项目地址

GameGen-O的应用场景

- 游戏原型制作:开发者可以使用 GameGen-O 快速制作游戏原型,测试不同的游戏元素,从而节省从零开始构建游戏的时间和精力。

- 环境和场景生成:GameGen-O 能够创造动态的游戏环境和复杂的场景,为游戏世界增添丰富的视觉效果。

- 动作和事件生成:模型支持生成复杂的角色动作和多种游戏事件,如海啸、龙卷风和火灾等,增强游戏的互动性和挑战性。

- 辅助游戏开发:GameGen-O 可以在游戏开发环节提供支持,通过 AI 模型替代部分开发工作,提高开发效率。

- 研究和教育:对于研究者和教育者而言,GameGen-O 可作为研究工具,帮助探索视频游戏 AI 开发、互动控制和沉浸式虚拟环境等领域。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号