GLM-4-Voice是智谱AI推出的一款前沿的情感语音交互模型,具备实时理解和生成中英文语音的能力。该模型能够根据用户的指令灵活调节语音的情感、语调、语速和方言等特征,旨在提供更加自然和流畅的人机交互体验。

GLM-4-Voice是什么

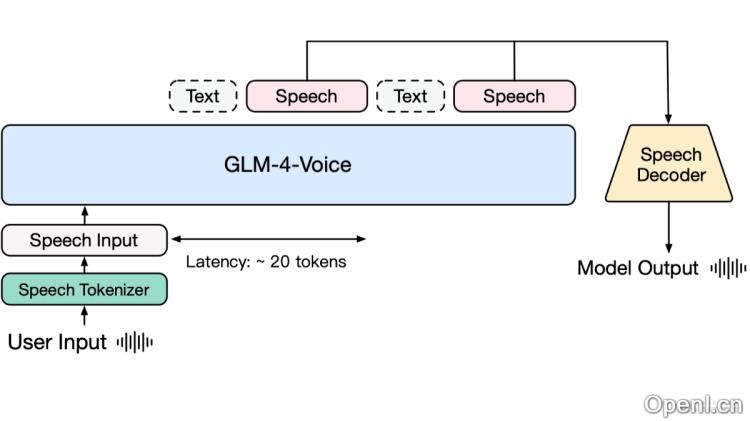

GLM-4-Voice是由智谱AI开发的端到端情感语音模型,旨在直接理解和生成中英文语音,支持实时的语音对话。其设计理念是通过端到端建模来减少信息损失,提升语音交互的自然性与流畅性,同时实现低延迟的实时对话,为用户带来更丰富的语音交互体验。该模型由三个主要部分构成:GLM-4-Voice-Tokenizer负责把连续语音转化为离散token,GLM-4-Voice-Decoder则实现将token转化为连续语音输出,而GLM-4-Voice-9B则是在GLM-4-9B模型的基础上进行预训练和对齐,以实现对语音的理解和生成。

GLM-4-Voice的主要功能

- 语音理解与生成:直接解析与生成中英文语音,实现顺畅的人机对话。

- 情感表达:能够模拟多种情感和语调,如快乐、悲伤、生气、恐惧等,使语音回复更显自然。

- 灵活调节语速:根据用户指令调节语速,适合不同的对话场景。

- 实时指令输入:支持用户随时中断语音输出,输入新指令以调整对话内容。

- 多语言与方言支持:支持中文及多种方言,如粤语、重庆话、北京话等。

- 低延迟交互:采用流式思考架构,低延迟实现高质量的语音对话。

GLM-4-Voice的技术原理

- 端到端建模:与传统的ASR + LLM + TTS级联方案相比,GLM-4-Voice在一个统一的模型中完成语音理解与生成,避免了信息损失。

- 音频Tokenizer:使用经过监督训练的音频Tokenizer将连续语音输入转化为离散token,以12.5Hz的低码率保存语义信息及副语言特征。

- 语音解码器:基于Flow Matching模型结构的解码器将离散的语音token转换为连续语音输出,最低只需10个token即可开始生成,降低对话延迟。

- 预训练与对齐:GLM-4-Voice-9B在GLM-4-9B的基础上进行了预训练和对齐,使其具备强大的音频理解与建模能力。

- 流式推理:支持流式推理,模型能够交替输出文本与语音,根据用户语音指令实时调整语音输出,确保回复内容的高质量。

GLM-4-Voice的项目地址

- 产品体验:体验链接

- 项目官网:zhipuai.cn/news

- GitHub仓库:https://github.com/THUDM/GLM-4-Voice

GLM-4-Voice的应用场景

- 智能助手:在智能手机和智能家居设备中作为智能助手,利用语音交互帮助用户完成任务,如设置提醒、查询天气和控制家居设备等。

- 客户服务:在客户服务中心作为虚拟客服,基于自然语言理解与语音合成技术,为用户提供咨询和问题解决服务。

- 教育与学习:在教育领域作为语言学习助手,帮助学生练习发音、听力与口语,提供个性化学习建议。

- 娱乐与媒体:在娱乐行业中用于语音合成,为动画、游戏和有声书等提供自然且富有表现力的语音输出。

- 新闻与播报:用于快速将文本新闻转化为语音,为需要语音信息的用户提供服务。

常见问题

- GLM-4-Voice支持哪些语言? GLM-4-Voice支持中文与英文,并具备多种中国方言的能力。

- 如何体验GLM-4-Voice? 用户可以通过提供的产品体验链接访问并使用GLM-4-Voice的功能。

- GLM-4-Voice的语音输出是否自然? 该模型通过情感表达和调节语速等功能,旨在提供自然流畅的语音输出体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号