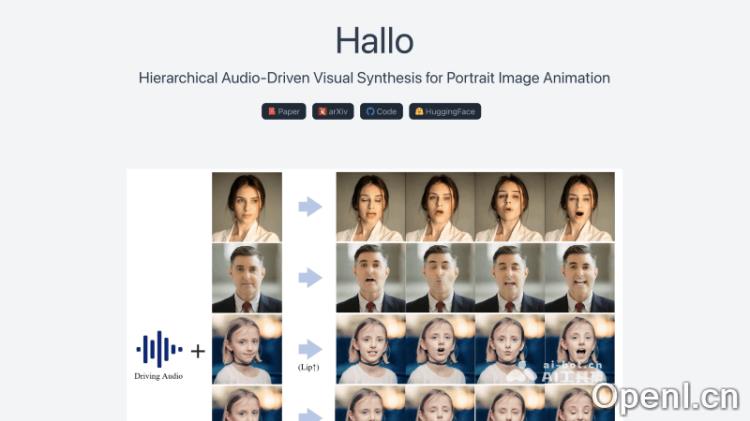

产品名称:Hallo

产品简介:Hallo是由复旦大学、百度公司、苏黎世联邦理工学院和南京大学的研究人员共同提出的一个AI对口型肖像图像动画技术,可基于语音音频输入来驱动生成逼真且动态的肖像图像视频。

详细介绍:

Hallo是什么

Hallo是由复旦大学、百度公司、苏黎世联邦理工学院和南京大学的研究人员共同提出的一个AI对口型肖像图像动画技术,可基于语音音频输入来驱动生成逼真且动态的肖像图像视频。该框架采用了基于扩散的生成模型和分层音频驱动视觉合成模块,提高了音频与视觉输出之间的同步精度。Hallo的网络架构整合了UNet去噪器、时间对齐技术和参考网络,以增强动画的质量和真实感,不仅提升了图像和视频的质量,还显著增强了唇动同步的精度,并增加了动作的多样性。

Hallo的功能特色

- 音频同步动画:Hallo利用先进的音频分析技术,将输入的语音音频与肖像图像相结合,生成动态的面部动画。通过精确的唇动同步算法,确保视频动画中的嘴唇动作与音频中的声音同步,从而创造出逼真的说话效果。

- 面部表情生成:根据音频信号中的情感和语调变化,Hallo能够自动识别并生成相应的面部表情,包括微笑、皱眉、惊讶等表情,使视频动画角色的“表演”更加自然和富有情感。

- 头部姿态控制:Hallo允许对视频动画中的头部姿态进行细致的调整,如头部的倾斜、转动等,使得视频动画能够更好地反映音频内容的意图和情感,增强视觉与听觉的协调性。

- 个性化动画定制:用户可以根据不同的应用场景和个人特征,对动画的风格、表情和动作进行定制。Hallo的个性化定制功能支持用户创造出独一无二的角色,满足特定的视觉和情感表达需求。

- 时间一致性维护:Hallo通过时间对齐技术,确保动画中的动作和表情在时间上流畅过渡,避免突兀和不自然的变化。

- 动作多样性:除了同步音频的基本动作外,Hallo还支持生成多样化的动作和风格。用户可以根据需要选择不同的动作库,为动画角色添加更多动态元素,如手势、眨眼等,从而丰富视频的表现力。

Hallo的官网入口

- 官方项目主页:https://fudan-generative-vision.github.io/hallo/#/

- GitHub代码库:https://github.com/fudan-generative-vision/hallo

- Hugging Face模型库:https://huggingface.co/fudan-generative-ai/hallo

- arXiv技术论文:https://arxiv.org/abs/2406.08801

Hallo的技术原理

- 分层音频驱动视觉合成:Hallo采用分层的方法来处理音频和视觉信息。这种分层结构允许模型分别处理嘴唇动作、面部表情和头部姿态,然后通过自适应权重将这些元素融合在一起。

- 端到端扩散模型:Hallo使用基于扩散的生成模型,一种从潜在空间生成数据的方法。在训练阶段,数据逐渐被加入噪声,然后在逆过程中去除噪声以重建清晰的图像。

- 交叉注意力机制:通过交叉注意力机制,Hallo能够在音频特征和视觉特征之间建立联系。该机制使得模型能够集中注意力于与当前音频输入最相关的面部区域。

- UNet去噪器:Hallo利用基于UNet的去噪器来逐步去除图像中的噪声,生成清晰的动画帧。UNet结构因其在图像分割任务中的有效性而闻名,通过跳跃连接使用低层特征图来提高生成质量。

- 时间对齐技术:为了保持动画在时间上的连贯性,Hallo采用了时间对齐技术,这有助于确保连续帧之间的平滑过渡和一致性。

- 参考网络(ReferenceNet):ReferenceNet用于编码全局视觉纹理信息,以实现一致且可控的角色动画,可帮助模型在生成过程中参考现有的图像,以增强输出的视觉质量。

- 面部和音频编码器:Hallo使用预训练的面部编码器来提取肖像的身份特征,同时使用音频特征编码器(如wav2vec)来将音频信号转换为可以驱动动画运动的信息。

- 自适应权重调整:Hallo允许调整不同视觉组件(如嘴唇、表情、姿态)的权重,以控制动画的多样性和细节。

- 训练与推理:在训练阶段,Hallo通过优化面部图像编码器和空间交叉注意力模块的参数来提高单帧生成能力。在推理阶段,模型结合参考图像和驱动音频来生成动画视频序列。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号