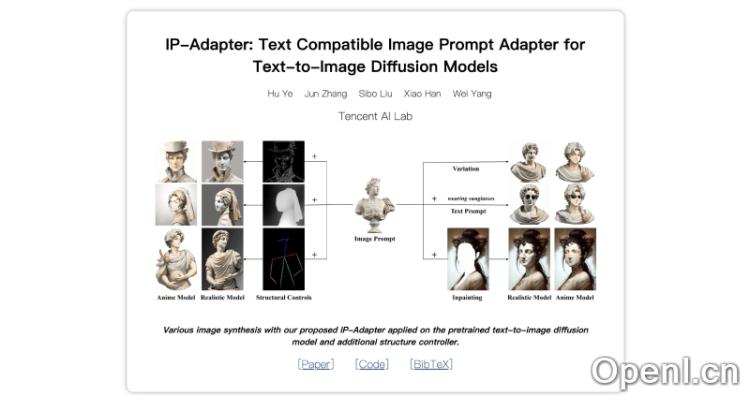

IP-Adapter是一种先进的图像生成工具,旨在通过结合图像提示与文本提示,提升预训练文本到图像扩散模型(如Stable Diffusion)的表现。该技术由腾讯AI实验室的研究团队研发,旨在简化用户通过文本生成理想图像时所面临的复杂性与挑战。

IP-Adapter是什么

IP-Adapter(Image Prompt Adapter)是一种为预训练的文本到图像扩散模型量身打造的适配器,旨在使模型能够直接利用图像提示(image prompt)进行图像生成。这一创新方法旨在克服仅依赖文本提示(text prompt)所带来的挑战。传统的文本到图像生成过程往往需要复杂的提示工程,而IP-Adapter通过引入图像提示,提升了模型理解图像内容的能力,从而更准确地生成符合用户期望的图像。

IP-Adapter的核心在于其独特的解耦交叉注意力机制,这种机制使得文本特征与图像特征的处理相互独立,从而增强了模型对图像信息的理解与运用。

主要功能

- 图像提示集成:支持将图像作为输入,与文本提示共同指导生成过程,充分利用图像信息,生成更贴合用户意图的图像。

- 轻量级设计:IP-Adapter的参数量约为22M,计算资源占用少,便于部署与应用。

- 广泛适用性:经过训练的IP-Adapter可灵活应用于其他基于相同基础模型微调的自定义模型,适应多种应用场景。

- 多模态生成:同时支持文本与图像提示,丰富了用户的创作方式,能够生成多样化的图像。

- 兼容结构控制:与现有的结构控制工具(如ControlNet)兼容,允许用户在生成过程中引入额外结构条件,如草图、深度图等,以实现更精确的图像控制。

- 无需微调:设计上避免对原始扩散模型进行微调,用户可以直接使用预训练模型,免去繁琐的微调过程。

- 图像到图像转换与修复:除了文本到图像生成外,IP-Adapter同样能够处理图像到图像的转换和修复任务,通过将文本提示替换为图像提示实现。

产品官网

- 官方项目主页:https://ip-adapter.github.io/

- GitHub代码库:https://github.com/tencent-ailab/IP-Adapter

- Arxiv研究论文:https://arxiv.org/abs/2308.06721

- Hugging Face 模型地址:https://huggingface.co/h94/IP-Adapter

- Google Colab Demo 地址:https://colab.research.google.com/github/tencent-ailab/IP-Adapter/blob/main/ip_adapter_demo.ipynb

- IP-Adapter-FaceID Demo:https://huggingface.co/spaces/multimodalart/Ip-Adapter-FaceID

应用场景

IP-Adapter适用于多个领域,包括艺术创作、广告设计、游戏开发等。艺术家可以利用IP-Adapter生成灵感图像,设计师可以创造出符合客户需求的视觉内容,而游戏开发者则可以用其生成游戏素材。此外,由于其多模态生成的特性,IP-Adapter也可以在教育和培训领域中发挥作用,帮助学生和专业人士更好地理解视觉与文本的关系。

常见问题

1. IP-Adapter是否需要特别的硬件支持?

虽然IP-Adapter的设计相对轻量,但为了获得较好的性能,推荐使用带有CUDA支持的GPU。

2. 如何开始使用IP-Adapter?

用户可以通过访问官方项目主页或GitHub代码库,获取安装和使用的相关说明。

3. IP-Adapter是否支持多语言?

是的,IP-Adapter支持多种语言的文本提示,用户可以根据需要选择语言进行图像生成。

4. 是否需要对模型进行微调才能使用?

不需要,IP-Adapter的设计使得用户可以直接在预训练模型上进行操作,无需额外的微调过程。

粤公网安备 44011502001135号

粤公网安备 44011502001135号