Loopy是字节跳动推出的一款基于音频驱动的AI视频生成模型,能够将静态照片转化为动态视频。该技术使得照片中的人物能够根据输入的音频文件进行面部表情和头部动作的同步,生成自然且逼真的动态效果。Loopy采用了先进的扩散模型技术,无需依赖额外的空间信号或条件,能够有效捕捉并理解长期运动信息,适用于娱乐、教育等多种场景。

Loopy是什么

Loopy是一款由字节跳动开发的音频驱动AI视频生成模型,用户可以将静态照片变为动态视频,照片中的人物根据指定的音频文件进行面部表情和头部动作的协调,创造出栩栩如生的动态效果。其技术基于先进的扩散模型,无需额外的空间信号或条件,能够捕捉并学习长期运动信息,生成自然流畅的动作,适合在娱乐、教育等多个领域应用。

Loopy的主要功能

- 音频驱动: Loopy能够根据输入的音频文件自动生成与之同步的动态视频。

- 面部动作生成: 动态视频中的人物嘴型、眉毛、眼睛等面部部位会自然地进行动作,仿佛在说话。

- 无需额外条件: 不同于一些需要额外信息的技术,Loopy可独立生成视频,无需辅助输入。

- 长期运动信息捕捉: 具备处理长期运动信息的能力,生成更加自然、流畅的动作效果。

- 多样化的输出: 根据输入的音频特征(如情感和节奏等),生成相应的面部表情和头部动作,展现多样化的表现效果。

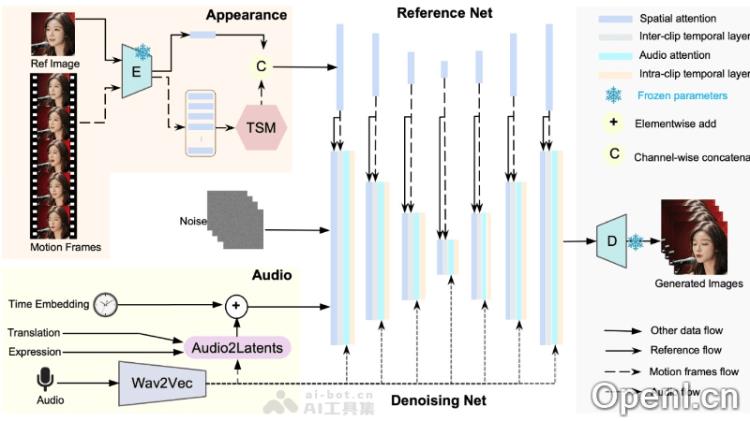

Loopy的技术原理

- 音频驱动模型: Loopy的核心在于音频驱动的视频生成模型,能够根据音频信号生成与之同步的动态视频。

- 扩散模型: 采用扩散模型技术,通过逐步引入噪声并学习逆向过程来生成视频数据。

- 时间模块: 设计了跨片段及片段内部的时间模块,使得模型能够理解并利用长期运动信息,从而生成更自然且连贯的动作。

- 音频到潜空间转换: 将音频信号转换为驱动面部动作的潜在表示。

- 运动生成: 从音频中提取特征和长期运动信息,生成对应的面部动作,如嘴型、眉毛、眼睛等部位的动态变化。

Loopy的项目地址

- 产品体验: 即梦AI – AI视频生成 – “对口型”功能

- 项目官网: https://loopyavatar.github.io/

- arXiv技术论文: https://arxiv.org/pdf/2409.02634

Loopy的应用场景

- 社交媒体与娱乐: 为社交媒体上的照片或视频增添动态效果,提升互动性和娱乐性。

- 电影与视频制作: 制作特效,让历史人物“复活”,创造生动的视觉体验。

- 游戏开发: 为游戏中的非玩家角色(NPC)生成更真实自然的面部表情与动作。

- 虚拟现实(VR)与增强现实(AR): 在VR或AR体验中,生成更加真实和沉浸式的虚拟角色。

- 教育与培训: 制作教育视频,模拟历史人物的演讲或重现科学实验过程。

- 广告与营销: 创造引人注目的广告内容,提升广告的吸引力和记忆度。

常见问题

Loopy如何处理输入的音频? Loopy使用音频信号提取特征,并将其转化为驱动面部动作的潜在表示,以生成动态视频。

我需要提供额外的信息吗? 不需要,Loopy能够独立生成视频,无需额外的空间信号或条件。

Loopy适用于哪些领域? Loopy广泛应用于社交媒体、娱乐、教育、游戏开发、广告等多个领域。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号