MLE-bench是什么

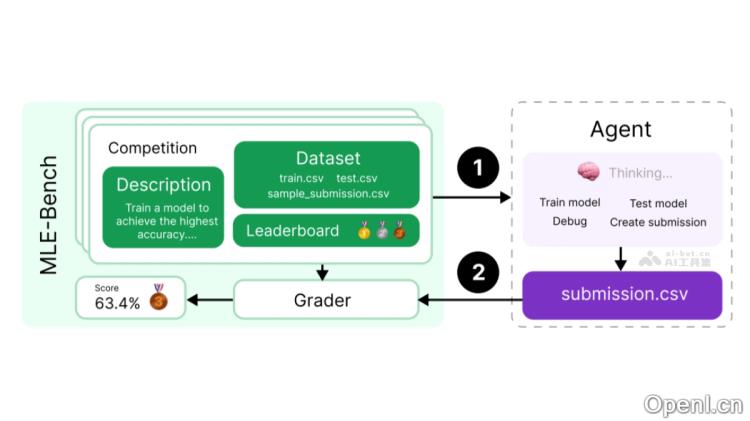

MLE-bench 是由 OpenAI 开发的一款基准测试工具,旨在评估 AI 代理(AI Agent)在机器学习工程任务中的表现。该测试包含75个从 Kaggle 选取的竞赛任务,涵盖自然语言处理、计算机视觉及信号处理等多个领域。AI 代理需要在此环境中执行任务,包括理解竞赛描述、处理数据集、训练模型及提交结果,最终通过排行榜上的得分来评估其能力。MLE-bench 的设计注重真实挑战,任务均源于实际的 Kaggle 竞赛,旨在全面评估 AI 代理在自动化机器学习工程方面的进展,并与人类专业水平进行比较。

MLE-bench的主要功能

- 性能评估:MLE-bench 提供一个标准化的平台,用于评估人工智能代理在机器学习工程任务中的表现。

- 任务模拟:从 Kaggle 精心挑选的75个竞赛任务中,模拟真实的机器学习工程挑战,涵盖自然语言处理、计算机视觉和信号处理等多个领域。

- 自主执行:支持 AI 代理在没有人类干预的情况下,自主完成从理解任务描述、数据预处理、模型训练到结果提交的整个流程。

MLE-bench的技术原理

- 数据集和任务设计:MLE-bench 从 Kaggle 中选取75个不同领域的竞赛,形成多样化的任务集合,每个任务都代表机器学习工程中的实际问题。

- 代理执行框架(Scaffolding):AI 代理在一个执行框架内运行,该框架提供必要的工具和接口,使 AI 能够完成数据读取、模型训练、生成提交文件等操作。

- 自动化评估:通过与 Kaggle 竞赛排行榜的比较,MLE-bench 自动评估 AI 代理的性能,并提供本地验证工具,以确保 AI 代理的提交符合标准。

- 资源管理:MLE-bench 支持调整计算资源和时间限制,以研究这些因素对 AI 代理性能的影响。

MLE-bench的项目地址

- GitHub仓库:https://github.com/openai/mle-bench/

- arXiv技术论文:https://arxiv.org/pdf/2410.07095

MLE-bench的应用场景

- AI 代理性能测试:利用 MLE-bench 测试和评估不同 AI 代理在机器学习工程任务中的表现,包括数据处理、模型训练和结果提交等。

- 机器学习模型开发:借助 MLE-bench 提供的环境开发和优化机器学习模型,模拟真实世界的竞赛任务,以提升模型的泛化能力。

- 算法研究与创新:研究人员可以使用 MLE-bench 探索新的算法和方法,解决机器学习工程中的实际问题,推动 AI 技术的进步。

- 教育与培训:在教育领域,MLE-bench 可作为教学工具,帮助学生理解和掌握机器学习工程的关键技能和最佳实践。

常见问题

- MLE-bench 的主要目标是什么?MLE-bench 旨在评估 AI 代理在机器学习工程任务中的表现,并提供一个标准化的测试环境。

- 如何参与 MLE-bench 测试?用户可以通过访问 GitHub 仓库,下载相关资源并按照说明进行测试。

- MLE-bench 适用于哪些领域?MLE-bench 的任务涵盖自然语言处理、计算机视觉和信号处理等多个领域。

- 如何评估 AI 代理的表现?MLE-bench 通过与 Kaggle 竞赛的排行榜比较,自动评估 AI 代理的性能,并提供反馈。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号