OmniParser是一款由微软研究院开发的屏幕解析工具,旨在将用户界面的屏幕截图转化为结构化的数据。这一工具专为提升基于大型语言模型(如GPT-4V)的用户界面代理系统的表现而设计,通过准确识别可交互图标和理解截图中元素的语义,增强代理执行任务的能力。

OmniParser是什么

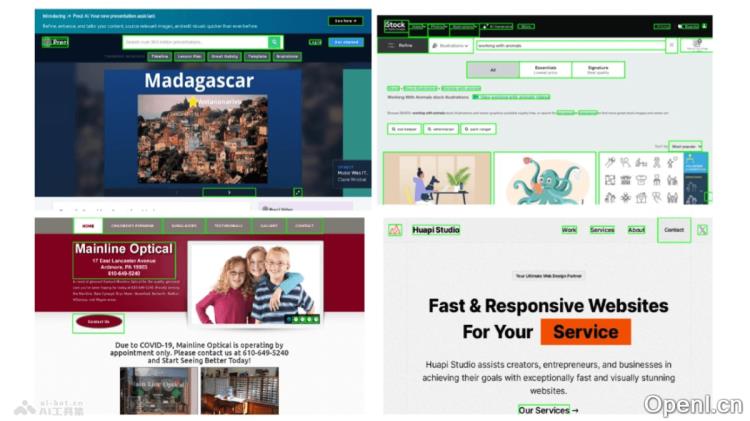

OmniParser是微软研究院推出的一种屏幕解析工具,能够将用户界面的屏幕截图转化为结构化的数据。该工具旨在提高基于大型语言模型(如GPT-4V)的用户界面代理系统的性能,通过精准识别可交互的图标和理解截图中的元素语义,增强代理执行任务的能力。OmniParser借助微调的模型来提取屏幕中的交互区域及其功能语义,在多个基准测试中显著提升了操作的准确性和代理的整体性能,而无需依赖额外的信息如HTML或视图层次结构。

OmniParser的主要功能

- 解析用户界面截图:将用户界面的屏幕截图转化为结构化元素,包括可交互的图标和文本。

- 识别可交互区域:使用专门的检测模型识别并标记用户界面中的可交互区域,如按钮和图标。

- 提取功能语义:运用描述模型提取检测到的元素的功能语义,为用户任务生成相关描述。

- 提升代理性能:结合解析结果,提高基于大型语言模型(如GPT-4V)的用户界面代理在执行任务时的精确度和效率。

- 跨平台兼容:支持多种操作系统和应用程序,包括Windows、MacOS、iOS、Android,以及多种Web浏览器和桌面应用。

- 独立数据提取:无需依赖HTML或视图层次结构等额外信息,能够独立从视觉截图中提取必要数据。

OmniParser的技术原理

- 数据集构建:从广泛使用的网页和应用中提取数据,构建可交互图标检测和描述的数据集。

- 模型微调:

- 检测模型:使用YOLOv8模型在可交互图标检测数据集上进行微调,以识别和定位用户界面中的可交互区域。

- 描述模型:使用BLIP-v2模型在图标描述数据集上进行微调,以生成图标的功能性描述。

- 集成OCR模块:结合光学字符识别(OCR)模块,从屏幕中提取文本,并与图标检测结果合并,同时去除重叠的边界框。

- 结构化表示:将检测到的元素和生成的描述整合,形成结构化的文档对象模型(DOM)表示,并在潜在可交互元素上叠加边界框的截图。

- 行动预测:结合结构化元素和功能语义,减轻大型语言模型在行动预测时的负担,更精准地将预测的行动转换为屏幕上的实际操作。

OmniParser的项目地址

- 项目官网:omniparser-for-pure-vision-based-gui-agent

- HuggingFace模型库:https://huggingface.co/microsoft/OmniParser

- arXiv技术论文:https://arxiv.org/pdf/2408.00203

OmniParser的应用场景

- 自动化软件测试:在软件开发过程中,自动识别和操作用户界面元素,以执行测试脚本,从而提高测试效率和覆盖率。

- 虚拟助手:作为虚拟助手的组成部分,帮助理解屏幕内容,执行诸如预订、查询和数据输入等任务。

- 辅助技术:为视觉障碍人士解析屏幕内容,并将其转换为语音输出,提供屏幕阅读功能。

- 用户界面设计验证:设计师可以验证用户界面设计中的可交互元素是否符合预期功能和语义。

- 跨平台应用开发:开发者在不同操作系统和设备上测试和优化应用的用户界面,确保用户体验的一致性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号