GPT-4o是一款由OpenAI推出的先进人工智能模型,具备出色的多模态推理能力,能够处理语音、文本和视觉信息。该模型可实时响应用户输入,并在音频交互中检测和模拟情感,从而提供更加自然和富有表现力的交流体验。相较于之前的模型,GPT-4o在运算速度上提高了一倍,同时成本降低了一半,展现出显著的性能优势。

GPT-4o是什么

GPT-4o是OpenAI推出的最新一代人工智能模型,具备强大的多模态推理能力,能够处理语音、文本和视觉信息。该模型可以实时响应用户输入,并在音频交互中识别和表达情感,从而提供更加自然和丰富的交流体验。GPT-4o的设计旨在提高运算速度并降低使用成本,其速度比前代模型快两倍,而成本仅为一半。该模型在多语言处理、音频和视觉理解方面表现优秀,同时在安全性设计上也进行了强化,以确保用户交互的安全性。目前,用户可以在ChatGPT中逐步体验到GPT-4o的文本和图像功能,后续还将推出音频和视频功能。

GPT-4o的主要功能

- 多模态交互:GPT-4o不仅支持文本处理,还能够处理语音和视觉信息,理解并回应更广泛的用户输入,包括实时视频分析。

- 实时对话反馈:该模型能够快速提供即时反馈,无论是在文本对话、语音交互还是视频内容分析中,平均响应时间仅为320毫秒,与人类对话反应时间相近。

- 情感识别与模拟:GPT-4o能够识别用户的情感状态,并在语音输出中模拟相应情感,使得对话更加贴近自然交流。

- 编程代码辅助:GPT-4o能够分析编程语言中的代码片段,帮助用户理解代码的功能和逻辑。用户可以通过语音向GPT-4o提问,模型会以语音形式回应,解释代码的运行原理或指出潜在问题。

- 多语言支持:GPT-4o支持超过50种语言,能够满足全球用户的需求,并支持多种语言的实时同声传译,例如将英语口译为意大利语。

GPT-4o的性能表现

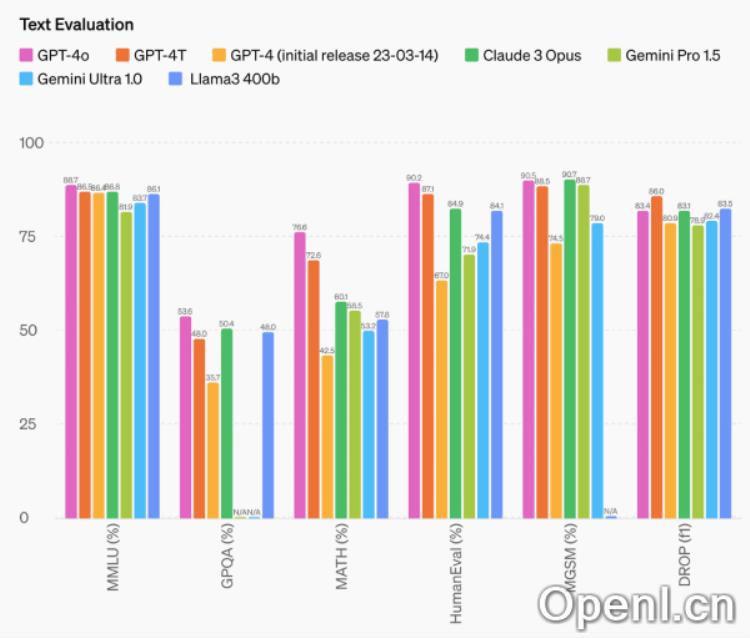

- 文本性能评估:GPT-4o在多语言理解均值(MMLU)基准测试中达到了87.2%的最高得分,在GPQA、MATH、HumanEval和MGSM等测试中也表现优异,显示出其强大的推理能力和文本处理能力。

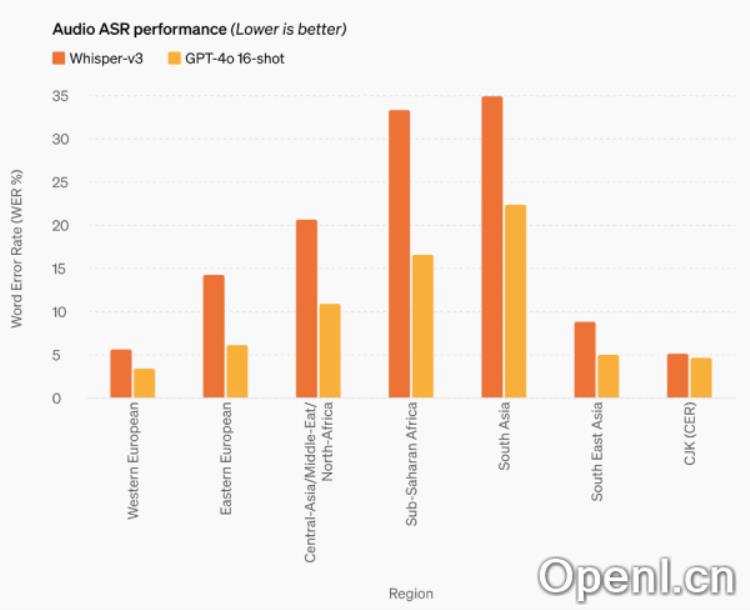

- 音频ASR性能:GPT-4o在语音识别性能上显著优于Whisper-v3,尤其在资源匮乏语言的识别上表现突出。

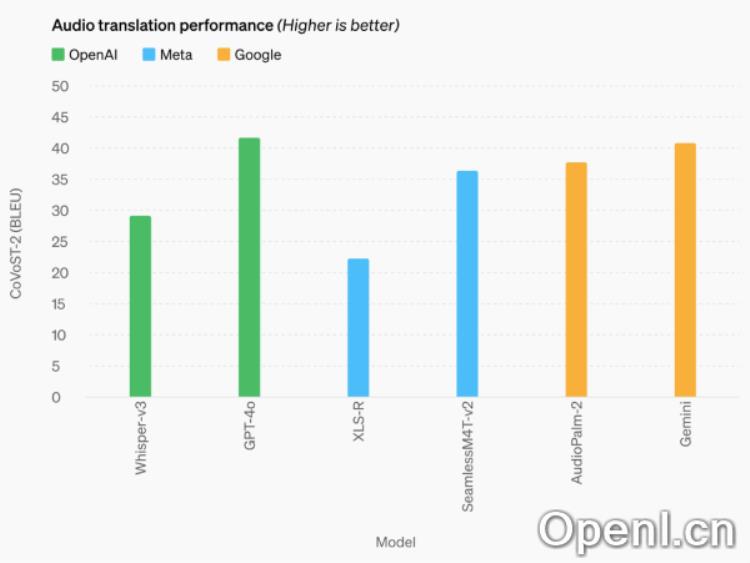

- 音频翻译性能:在语音翻译方面,GPT-4o达到了新的领先水平,在MLS基准测试中超越了Whisper-v3、Meta的SeamlessM4T-v2和谷歌的Gemini。

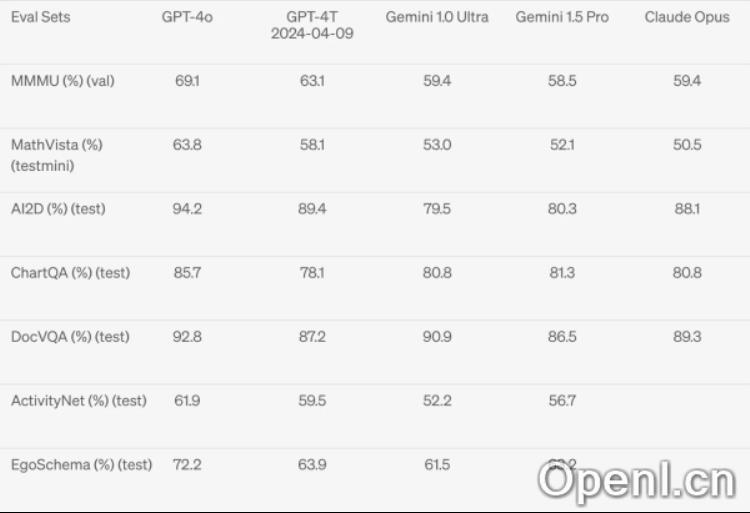

- 视觉理解评估:GPT-4o在视觉感知基准上实现了最先进的性能,超越了Gemini 1.0 Ultra、Gemini 1.5 Pro和Claude 3 Opus。

GPT-4o与GPT-4 Turbo的对比

- 价格:GPT-4o的使用成本比GPT-4 Turbo低50%,具体来说,输入和输出的标记(tokens)价格分别为每百万(M)输入5美元和每百万输出15美元。

- 速率限制:GPT-4o的处理速率是GPT-4 Turbo的5倍,每分钟可以处理高达1000万个token。

- 视觉能力:在视觉能力的相关评估中,GPT-4o表现优于GPT-4 Turbo。

- 多语言支持:GPT-4o在非英语语言的支持上有所提升,比GPT-4 Turbo提供更优的性能。

目前,GPT-4o的上下文窗口为128k,知识截止日期为2023年10月。

如何使用GPT-4o

GPT-4o的文本和图像功能已经开始在ChatGPT中逐步推出,用户可在ChatGPT平台上免费体验相关功能,但免费版有使用次数限制。Plus用户的消息限制将比免费用户高出5倍。

此外,OpenAI计划在未来几周内推出基于GPT-4o的Voice Mode新版本,作为ChatGPT Plus的一个alpha版本提供给Plus用户。同时,GPT-4o也将通过API提供给开发者,让他们可以将GPT-4o集成到自己的应用程序中,API中相比GPT-4 Turbo更快、更便宜且拥有更高的速率限制。

关于GPT-4o的音频和视频功能,OpenAI将在接下来的几周和几个月内继续开发技术基础设施,提升可用性并确保安全性,之后将逐步向公众发布。

了解更多信息,请访问官方博客:Hello GPT-4o

粤公网安备 44011502001135号

粤公网安备 44011502001135号