Qwen2是一款由阿里云通义千问团队开源的前沿大语言模型,涵盖了从0.5B到72B的多个规模。该模型在中文和英文的基础上,融合了27种语言的高质量数据,显著提升了自然语言理解、代码生成、数学解题以及多语言处理的能力。Qwen2支持最长达到128K tokens的上下文长度,强化了模型的泛化能力和应用潜力,在多个评测标准中表现优越,领先于Meta的Llama-3-70B,目前已在Hugging Face和ModelScope平台开源。

Qwen2是什么

Qwen2是阿里云通义千问团队推出的一款新一代开源大语言模型。该系列模型的参数规模从0.5B到72B不等,并且在中文和英文之外,增加了27种语言的优质数据,从而大幅提升了模型在自然语言理解、代码撰写、数学问题解决以及多语言处理方面的表现。Qwen2能够处理最长128K tokens的上下文,优化了模型的泛化性和应用潜力。该系列在多个评测基准上表现出色,超越了Meta的Llama-3-70B模型,目前已在Hugging Face和ModelScope平台上开放下载。

Qwen2的模型信息

| 模型名称 | 参数量 (B) | 非Embedding参数量 (B) | 是否使用GQA | 是否Tie Embedding | 上下文长度 (tokens) |

|---|---|---|---|---|---|

| Qwen2-0.5B | 0.49 | 0.35 | 是 | 是 | 32K |

| Qwen2-1.5B | 1.54 | 1.31 | 是 | 是 | 32K |

| Qwen2-7B | 7.07 | 5.98 | 是 | 否 | 128K |

| Qwen2-57B-A14B | 57.41 | 56.32 | 是 | 否 | 64K |

| Qwen2-72B-Instruct | 72.71 | 70.21 | 是 | 否 | 128K |

- 参数量:指模型的总参数数量,以B(十亿)为单位。

- 非Embedding参数量:不包括词嵌入部分的参数数量。

- 是否使用GQA:标识模型是否采用GQA(Generalized Query Answering)技术。

- 是否Tie Embedding:指出模型是否在输入和输出层共享参数。

- 上下文长度:模型能够处理的最大上下文长度,以tokens为单位。

Qwen2的官网入口

- 官方博客介绍:https://qwenlm.github.io/zh/blog/qwen2/

- GitHub地址:https://github.com/QwenLM/Qwen2

- Hugging Face地址:https://huggingface.co/Qwen

- ModelScope地址:https://modelscope.cn/organization/qwen

- Hugging Face在线Demo:https://huggingface.co/spaces/Qwen/Qwen2-72B-Instruct

Qwen2的模型评测

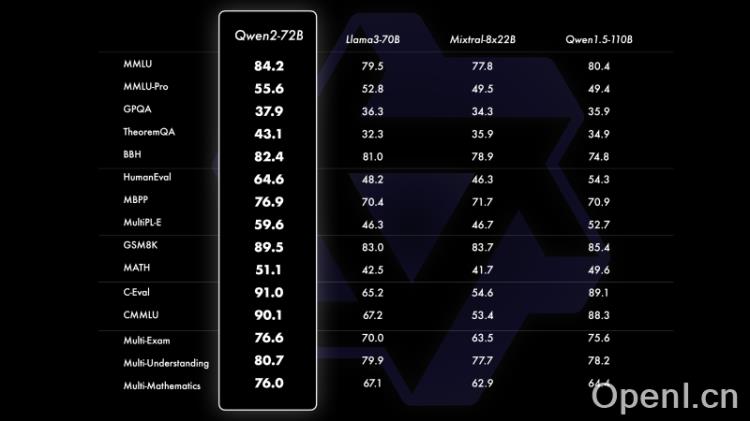

- Qwen2系列在多个评测基准上表现卓越,尤其是Qwen2-72B模型,实现了显著的性能提升。

- 在自然语言理解、知识处理、代码生成、数学能力和多语言支持等方面,Qwen2-72B明显超越了现有的领先模型,如Llama-3-70B和Qwen1.5的110B模型。

- 在16个评测中,Qwen2-72B-Instruct展现了基础能力与人类价值观对齐的良好平衡,超越了Qwen1.5的72B模型,并与Llama-3-70B-Instruct相抗衡。

Qwen2的模型亮点

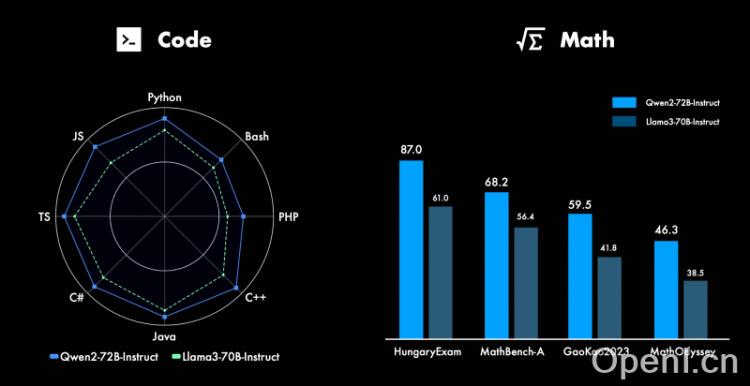

- 代码与数学:Qwen2在代码生成和数学能力方面的提升显著,成功借鉴了CodeQwen1.5的经验,在多种编程语言上取得了优秀效果。通过大规模高质量的数据支持,数学能力得到了质的飞跃。

- 长文本处理:Qwen2系列的Instruct模型在32K上下文长度上进行训练,并通过YARN等技术扩展至更长上下文,Qwen2-72B-Instruct能够有效处理128K上下文长度的信息提取任务。

- 安全性:在多语言不安全查询的评测中,Qwen2-72B-Instruct的安全性与GPT-4相当,且明显优于Mistral-8x22B模型,显著降低了生成有害内容的风险。

- 多语言能力:Qwen2在多语言能力的评测中表现突出,增强了对27种语言的处理能力,并优化了语言转换的效果,大幅降低了模型在语言转换时的错误率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号