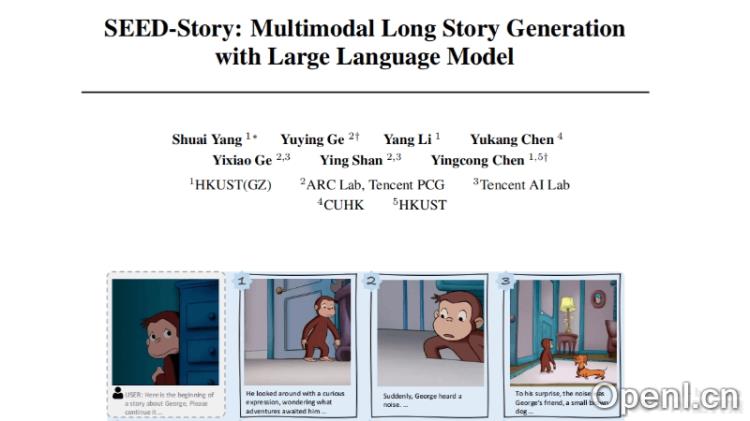

SEED-Story是由腾讯与香港科技大学、香港中文大学共同研发的一款创新性多模态故事生成模型。该模型基于多模态大语言模型(MLLM),能够同时预测文本和视觉token,并通过视觉de-tokenizer生成风格一致的图像。凭借引入的多模态注意力机制,SEED-Story支持生成长达25个序列的连贯叙事。

SEED-Story是什么

SEED-Story是腾讯与香港科技大学、香港中文大学合作开发的一款多模态故事生成模型。它利用多模态大语言模型(MLLM)来预测文本与视觉token,并通过视觉de-tokenizer生成具有一致风格的图像。SEED-Story采用多模态注意力机制,能够生成长达25个序列的连贯故事。此外,SEED-Story还提供了名为StoryStream的大规模高分辨率数据集,用于模型的训练和评估。

SEED-Story的主要功能

- 多模态故事生成:SEED-Story能够根据用户提供的起始图像和文本,生成包含连贯叙述和风格一致图像的长篇故事。

- 多模态注意力汇聚机制:引入了多模态注意力汇聚机制,使得模型能够高效自回归地生成故事,支持生成长达25个序列的内容。

- 大规模数据集:发布了名为StoryStream的高分辨率数据集,用于训练模型并从多方面评估多模态故事生成的效果。

- 故事指令调整:在故事生成过程中,SEED-Story通过指令调整对模型进行微调,以预测故事的下一个图像和文本。

- 可视化和交互:提供可视化比较,展示生成的图像在质量和一致性上优于其他基线模型。

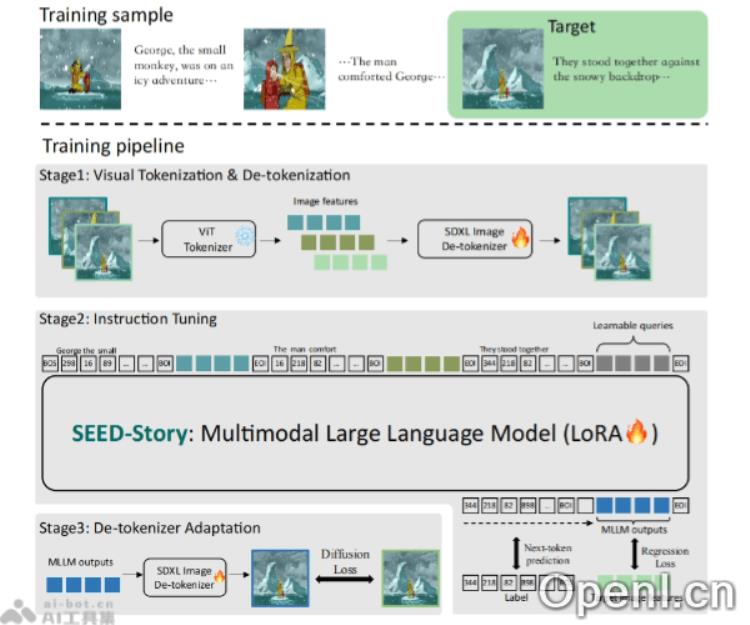

SEED-Story的技术原理

- 多模态大语言模型(MLLM):该技术利用大型语言模型来理解、生成和预测文本及视觉元素,能够处理并生成文本数据,同时理解并生成视觉内容。

- 文本和视觉标记预测:SEED-Story能够准确预测文本标记(文本中的元素或单词)和视觉标记(图像中的元素)。

- 视觉de-tokenizer:将语言模型生成的文本和视觉标记转化为图像,通过视觉de-tokenizer生成风格一致的高质量图像。

- 多模态注意力机制:引入该机制,使模型在生成故事时能够关注文本与图像之间的相互关系,从而更有效地处理长序列生成任务。

- 自回归生成:模型采用自回归方式生成故事,即每个新生成的标记依赖于之前生成的所有标记,确保故事的连贯性。

- 长序列生成能力:通过多模态注意力机制,SEED-Story能够生成比训练序列更长的故事。

- StoryStream数据集:提供一个高分辨率大规模数据集,用于训练模型并评估多模态故事生成任务,数据集包含视觉吸引的高分辨率图像及详细叙述文本。

- 训练流程:包括预训练去标记器以重建图像、采样交错图像文本序列进行训练,并利用MLLM的回归图像特征来优化生成图像。

SEED-Story的项目地址

- GitHub仓库:https://github.com/TencentARC/SEED-Story

- HuggingFace模型库:https://huggingface.co/TencentARC/SEED-Story

- arXiv技术论文:https://arxiv.org/abs/2407.08683

SEED-Story的应用场景

- 创意写作辅助:为作家和内容创作者提供灵感,帮助他们生成故事大纲、角色描述和情节发展。

- 教育与学习:作为教学工具,帮助学生理解故事叙述结构,提高他们的写作和创意思维能力。

- 娱乐与游戏开发:在视频游戏中生成动态故事线和角色背景,增强沉浸式体验。

- 广告与营销:快速生成引人注目的广告故事或营销材料,提升广告内容的吸引力和个性化。

- 电影与动画制作:辅助剧本创作,生成角色对话和场景描述,加速制作流程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号