Show-o是什么

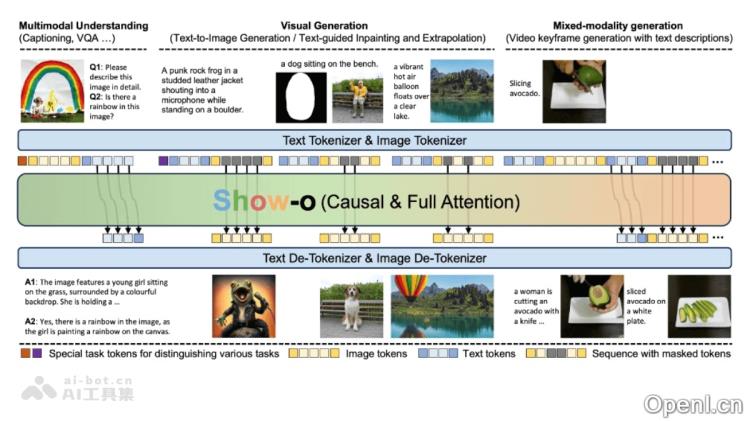

Show-o是一款集成了多模态理解与生成能力的统一Transformer模型。它通过结合自回归和离散扩散建模技术,灵活应对多种视觉语言任务,包括视觉问答、文本生成图像、文本引导的修复与扩展,以及混合模态生成等。Show-o在多模态理解和生成的基准测试中表现出色,其性能可与现有的专业模型相媲美,甚至更优。此外,它显著减少了图像生成所需的采样步骤,从而提升了效率。Show-o支持多种下游应用,如文本引导的图像修复和扩展,且无需额外的微调。

Show-o的主要功能

- 视觉问题回答(VQA):能够理解图像内容并回答与之相关的问题。

- 文本到图像生成:根据文本描述生成相应的图像,支持创意和多样化的视觉输出。

- 文本引导的图像修复(Inpainting):识别图像中的缺失部分,并根据文本提示进行有效修复。

- 文本引导的图像扩展(Extrapolation):在已有图像中添加新元素或扩展内容,基于文本描述进行拓展。

- 混合模态生成:结合文本描述生成视频关键帧,为长视频的生成开辟新途径。

- 多模态理解与生成:整合视觉与语言信息,有效处理复杂的多模态任务。

Show-o的技术原理

- 自回归与离散扩散建模的结合:Show-o模型独特地将自回归与离散扩散建模相结合,灵活处理各种不同的输入和输出模态。

- 基于预训练的大型语言模型(LLM):Show-o的架构基于预训练的LLM,并在每个注意力层之前引入QK-Norm操作,提升了模型的稳定性与性能。

- 离散图像标记:采用离散去噪扩散模拟离散图像标记,简化了对额外文本编码器的需求。

- 统一的提示策略:设计了一种统一的提示策略,将图像和文本标记化后形成输入序列,以适应多种任务,如多模态理解和文本到图像生成。

- 全注意力机制:引入全注意力机制,根据输入序列的类型自适应地应用因果注意力或全注意力,文本标记使用因果注意力,而图像标记则使用全注意力,将每个图像标记与序列中的所有标记相互作用。

- 训练目标:采用下一令牌预测(NTP)和遮罩令牌预测(MTP)两种学习目标,进行自回归与(离散)扩散建模。

- 混合模态生成潜力:展现了基于文本描述与视频关键帧的混合模态生成的潜力,为长视频生成提供了新思路。

- 降低采样步骤:相较于自回归图像生成,Show-o所需的采样步骤减少了约20倍,降低了计算资源的消耗,提升了模型的应用灵活性。

Show-o的项目地址

- Github仓库:https://github.com/showlab/Show-o

- arXiv技术论文:https://arxiv.org/pdf/2408.12528

- 在线体验Demo:https://huggingface.co/spaces/showlab/Show-o

Show-o的应用场景

- 社交媒体内容创作:用户可以通过提供文本描述,Show-o能够生成相应的图像或视频,丰富社交媒体帖子的内容。

- 虚拟助手:在虚拟环境中,Show-o可以根据用户的查询或指令生成解释性图像或动画,提供视觉辅助。

- 教育和培训:Show-o能够生成教学材料中的图表、图解和示例图像,提升学习体验。

- 广告和营销:根据产品描述或营销创意,Show-o能够快速生成吸引人的视觉内容,助力广告宣传。

- 游戏开发:Show-o可以为视频游戏设计生成独特的环境、角色及道具图像。

- 电影和视频制作:Show-o在前期制作中提供辅助,根据剧本生成概念艺术和场景设计图。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号