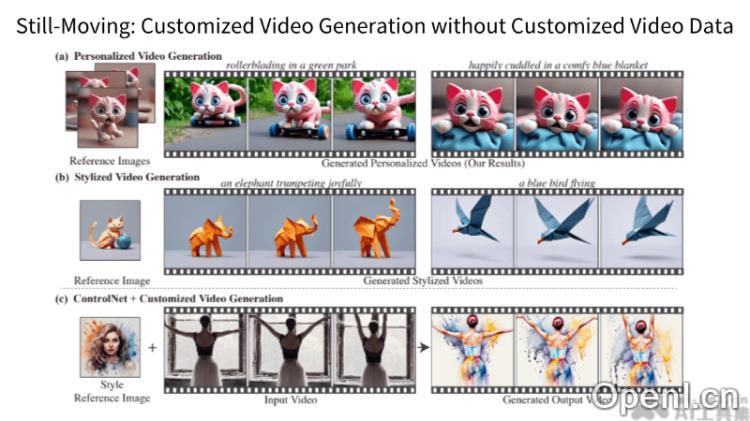

Still-Moving是DeepMind推出的一款先进的AI视频生成框架,旨在帮助用户轻松定制文本到视频(T2V)模型,无需依赖特定的视频数据。这一创新的技术通过训练轻量级的空间适配器,使得静态图像中的特征能与T2V模型的运动特性相一致,从而实现生动的动态视频生成。

Still-Moving是什么

Still-Moving是DeepMind研发的一种AI视频生成框架,允许用户根据自身需求定制文本到视频(T2V)模型,而无须提供特定的视频数据。这一框架通过训练轻量级的空间适配器,能够在静态图像上调整文本到图像(T2I)模型的特征,以匹配T2V模型的运动特性。这种方法不仅保留了T2I模型的个性化与风格化特点,还结合了T2V模型的动态能力,为视频制作提供了一种高效且无需额外数据的解决方案。

Still-Moving的主要功能

- 个性化视频生成:允许用户将自定义的文本到图像(T2I)模型权重整合到文本到视频(T2V)模型中。

- 无需专门的视频数据:该框架能够在没有特定视频数据的情况下进行有效训练,从而简化了数据收集与处理的要求。

- 轻量级空间适配器:通过训练适配器来调整T2I模型的特征,使其与T2V模型的运动特性相一致。

- 运动适配器模块:在训练期间使用,帮助模型学习如何在静态图像中模拟运动效果。

- 测试时移除运动适配器:在最终应用中,仅保留空间适配器,从而恢复T2V模型的原始运动特性。

Still-Moving的技术原理

- T2I模型定制:用户可以创建一个独特的文本到图像(T2I)模型,以满足特定的风格和内容需求。

- 空间适配器训练:为将T2I模型的定制权重整合到视频生成中,Still-Moving训练轻量级的空间适配器,确保其特征与视频模型的运动特性相匹配。

- 运动适配器模块:在训练阶段协助模型学习如何在由定制T2I模型生成的静态图像中引入运动效果。

- 静态视频训练:适配器是在由定制T2I模型生成的图像样本构建的静态视频上进行训练的,允许模型在没有实际运动数据的情况下模拟运动。

- 测试时的适配器移除:在测试阶段,运动适配器模块被移除,仅保留经过训练的空间适配器,从而使T2V模型恢复其原有的运动特性,同时遵循定制的T2I模型的空间特征。

- 先验知识整合:通过这种方式,Still-Moving能够将T2I模型的个性化与风格化特征与T2V模型的运动特性无缝结合,生成符合用户需求的自然运动视频。

Still-Moving的项目地址

- arXiv技术论文:https://arxiv.org/pdf/2407.08674

Still-Moving的应用场景

- 个性化视频制作:用户能够根据自身需求,生成具有特定角色、风格或场景的视频内容。

- 艺术创作:艺术家和设计师可以使用Still-Moving创作独特的视频艺术作品,将静态图像转化为动态视频。

- 内容营销:企业和品牌可以利用该框架生成引人注目的视频广告或社交媒体内容,以增强用户参与度。

- 电影和游戏制作:在电影后期制作或游戏开发中,Still-Moving能够快速生成或编辑视频素材,提高制作效率。

- 虚拟现实和增强现实:在VR和AR应用中,Still-Moving可以生成逼真的动态背景或角色,提升用户体验。

常见问题

- Still-Moving是否容易上手?:是的,Still-Moving的设计旨在简化用户体验,使用户能够快速上手生成视频。

- 我需要提供视频数据吗?:不需要,Still-Moving可以在没有特定视频数据的情况下进行训练。

- 可以用于商业用途吗?:当然可以,Still-Moving非常适合用于内容制作和营销等多个商业领域。

- 支持哪些平台?:Still-Moving可以在多种平台上运行,具体取决于用户的需求和技术环境。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号