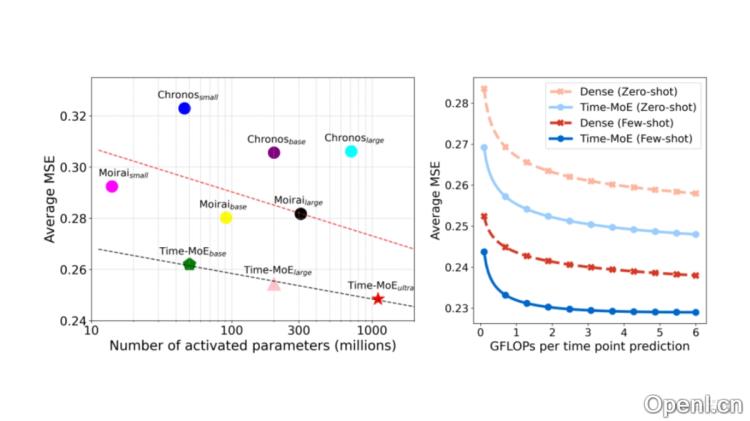

Time-MoE是一个前沿的时间序列基础模型,采用混合专家(Mixture of Experts,MoE)架构,能够将时间序列预训练模型的参数规模扩展到十亿级别。通过稀疏激活机制,Time-MoE在执行预测任务时,仅激活部分网络节点,从而显著提高计算效率并降低计算成本。该模型支持任意长度的输入和输出,能够处理从短期到长期的各类时序预测任务。Time-MoE在全新构建的大规模数据集Time-300B上进行预训练,该数据集包含超过3000亿个时间点,涵盖9个以上的领域,是当前最大的公开时间序列数据集,为模型的训练提供了丰富的多领域数据,确保了其在多种任务中的卓越泛化能力。

Time-MoE是什么

Time-MoE是一个创新的时间序列基础模型,基于混合专家(Mixture of Experts,MoE)架构,能够扩展至十亿级别的参数规模。该模型通过稀疏激活机制,仅在预测时激活部分网络节点,从而有效提升计算效率和降低成本。Time-MoE支持任意长度的输入和输出,适用于多种时序预测任务,涵盖从短期预测到长期预测的广泛应用。它在新推出的大规模数据集Time-300B上进行了预训练,包含超过3000亿个时间点,并覆盖多个领域,为模型训练提供了丰富的多样性数据,确保其在多种任务中的优秀泛化能力。

Time-MoE的主要功能

- 高精度时序预测:在各个领域和应用场景中,Time-MoE能实现高精度的时间序列预测。

- 灵活的输入输出范围:模型支持任意长度的输入和输出,适合多种时序预测任务。

- 多分辨率预测:具备不同尺度的预测能力,为模型提供了更大的灵活性。

- 预训练能力:在Time-300B大规模数据集上进行预训练,能够捕捉复杂的时间依赖关系。

- 卓越的泛化能力:基于多领域数据的训练,使模型在不同任务中展现出优异的泛化能力。

Time-MoE的技术原理

- 混合专家架构(MoE):通过稀疏激活机制,仅在预测时激活部分网络节点,提高计算效率。

- 自回归机制:采用仅包含解码器的Transformer模型,支持灵活的预测范围。

- 点式分词与编码:对时间序列数据进行点式分词和编码,保持时间信息的完整性。

- 多头自注意力与稀疏混合专家层:使用多头自注意力机制和稀疏混合专家层处理编码后的序列。

- 多任务学习:在训练过程中优化不同分辨率的预测头,提升模型的泛化能力。

Time-MoE的项目地址

- GitHub仓库:https://github.com/Time-MoE/Time-MoE

- HuggingFace模型库:https://huggingface.co/datasets/Maple728/Time-300B(Time-300B数据集)

- arXiv技术论文:https://arxiv.org/pdf/2409.16040

Time-MoE的应用场景

- 能源管理:预测电力需求、能源消耗或可再生能源产量,协助优化能源分配,降低运营成本。

- 金融预测:分析及预测股票市场价格、汇率或经济指标,为投资决策提供数据支持。

- 电商销量预测:预测产品的销售量,帮助企业进行库存管理及调整销售策略。

- 气象预报:预测天气趋势,为农业、交通、旅游等行业提供关键的气象信息。

- 交通规划:预测交通流量及拥堵情况,为城市交通管理和规划提供辅助决策。

常见问题

- Time-MoE适用于哪些领域?:Time-MoE可广泛应用于能源、金融、电子商务、气象和交通等多个领域。

- 如何获取Time-MoE模型及数据?:用户可以通过GitHub和HuggingFace模型库获取Time-MoE模型及其数据集。

- Time-MoE的预训练数据集有多大?:Time-MoE在包含超过3000亿个时间点的大规模数据集Time-300B上进行预训练。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号