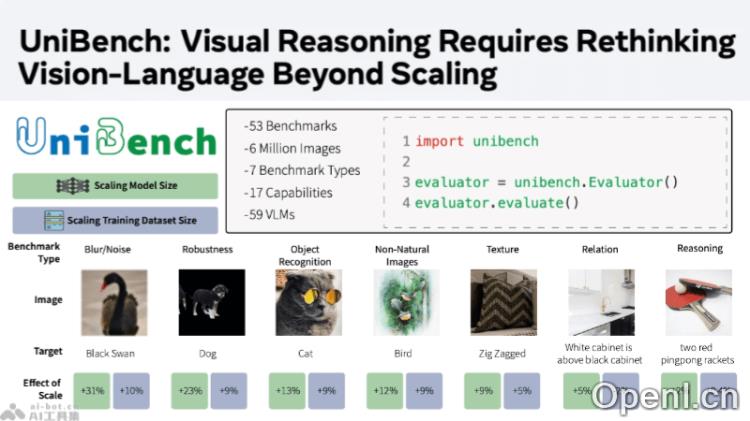

UniBench是Meta FAIR机构推出的一个全面的视觉语言模型(VLM)评估框架,旨在通过超过50项基准测试,系统性地评估各种视觉语言模型在物体识别、空间理解和推理等多个维度的表现。

UniBench是什么

UniBench是由Meta FAIR团队开发的视觉语言模型(VLM)评估工具,致力于对视觉语言模型进行全面的性能测试。该框架内置50多个基准测试,覆盖物体识别、空间理解和推理等多种能力。Meta FAIR还引入了”自学习评估器”,通过合成数据进行训练,显著降低了对人工标注的依赖,其性能超越了如GPT-4等主流模型评测工具。

UniBench的主要功能

- 全面评估:提供超过50个精确分类的基准测试,涵盖物体识别、空间理解、推理等多项视觉语言能力。

- 统一接口:简化了模型和基准测试的集成流程,提升了评估的灵活性与扩展性。

- 性能分析:生成丰富的可视化图表,帮助研究人员深入理解模型的优劣势。

- 数据集支持:兼容多种数据集,包括torchvision数据集及定制数据集。

- 处理器抽象:将评估逻辑抽象为可复用的处理器,便于新评估方法的快速集成。

UniBench的技术原理

- 基准测试设计:精心设计的50多个基准测试,确保评估的广泛性与深入性。

- 统一评估接口:提供标准化接口,便于研究人员轻松添加新模型或基准测试。

- 模块化架构:采用模块化设计,将评估逻辑抽象为可复用的处理器(handlers),简化评估方法的集成。

- 数据集兼容性:支持多种类型的数据集,提升评估的适应性。

- 性能分析工具:提供详细的性能分析工具,生成多种可视化图表,帮助深入理解模型性能。

- 精简评估集:通过分析基准测试之间的相关性,筛选出最具代表性的基准测试,降低全面评估的计算成本。

- 自动化与人工审核:结合自动化筛选与人工审核,确保评估样本质量,减少数据泄露并提升评估公正性。

- 多模态增益/泄露度量:引入多模态增益(MG)和多模态泄露(ML)指标,量化模型在多模态任务中的表现提升和数据泄露情况。

UniBench的项目地址

UniBench的应用场景

- 学术研究:为研究人员提供统一的工具来评估与比较不同视觉语言模型的性能。

- 模型开发:协助开发者测试与优化其视觉语言模型,通过基准测试迅速识别模型的强项与薄弱环节。

- 教育领域:作为教学工具,帮助学生理解视觉语言模型的工作机制与评估方法。

- 工业应用:在自动化图像分析、智能监控、自动驾驶等领域,评估视觉语言模型的实际应用效果。

- 产品测试:企业可以利用UniBench对集成视觉语言功能的产品进行全面测试,以确保产品质量。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号