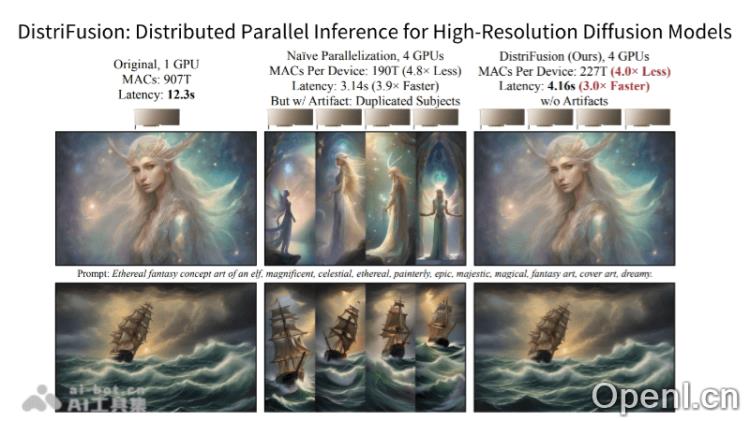

DistriFusion是一种高分辨率扩散模型的分布式并行推理框架,旨在通过多GPU的分布式推理显著提升图像生成速度。该框架利用patch parallelism技术,将图像切分并分配给不同的计算设备,实现高达6倍的推理速度提升,且无需额外训练,同时保持生成图像的高质量。DistriFusion的创新实现为人工智能内容创作和并行计算的研究提供了新的基准。

DistriFusion是什么

DistriFusion是一种专为高分辨率扩散模型设计的分布式并行推理框架。它通过多GPU的分布式推理,大幅加速了图像生成过程。DistriFusion运用patch parallelism技术,将高分辨率图像切分成多个小块,并将这些小块分配给不同的设备进行处理。该框架无需额外的训练即可实现最高6倍的推理速度提升,同时确保图像质量不受影响。DistriFusion为AI内容创作和并行计算的研究提供了全新的标准。

DistriFusion的主要功能

- 分布式推理:在多个GPU上并行执行扩散模型的推理,加速图像生成过程。

- 图像切分:高分辨率图像被切分为多个小块,各自处理实现并行计算。

- 无需额外训练:DistriFusion可直接应用于现有扩散模型,如Stable Diffusion XL,无需进行额外训练。

- 保持图像质量:在加速生成的同时,通过优化技术确保生成图像的高质量。

- 异步通信机制:支持异步数据交换,减少因通信开销导致的延迟。

DistriFusion的技术原理

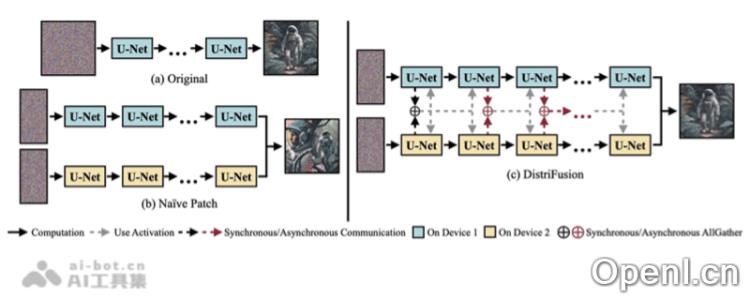

- Patch Parallelism(分片并行):将输入图像分割成多个小块,各块可以在不同的GPU上处理,从而实现并行化。

- 异步通信:在并行处理过程中,采用异步通信机制,支持GPU之间的数据交换而不阻塞计算,提升效率。

- 利用扩散过程的相似性:DistriFusion利用扩散模型中相邻步骤输入的高度相似性,通过重用前一时间步骤的特征映射为当前步骤提供上下文信息。

- 位移补丁并行性(Shifted Patch Parallelism):在每个时间步骤中对补丁进行小的位移,模拟补丁间的交互,避免显式的全局通信。

- 流水线化计算:设计允许将计算过程流水线化,使不同GPU能够在不同时间步骤上同时工作,进一步提高处理速度。

- 无需牺牲图像质量:在极大提升图像生成速度的同时,确保生成图像的质量不会下降。

- 适用多种扩散模型:DistriFusion可广泛应用于多种现有扩散模型,迅速实现加速效果。

DistriFusion的产品官网

- GitHub仓库:https://github.com/mit-han-lab/distrifuser

- arXiv技术论文:https://arxiv.org/pdf/2402.19481

DistriFusion的应用场景

- AI艺术创作:DistriFusion能够快速生成高质量图像,助力艺术家和设计师实现创意。

- 游戏与电影制作:在视觉效果制作中,DistriFusion能够加速渲染,缩短制作周期。

- 虚拟现实(VR)和增强现实(AR):DistriFusion可迅速生成逼真的3D环境和场景,提升用户体验。

- 数据可视化:在数据分析领域,DistriFusion用于生成复杂的可视化图像,帮助用户更直观地理解数据。

- 广告与营销:DistriFusion可快速创造引人注目的广告图像和营销材料,提高广告的吸引力和效果。

常见问题

- Q:DistriFusion是否需要额外训练才能使用?

A:不需要,DistriFusion可以直接应用于现有的扩散模型,无需额外训练。 - Q:使用DistriFusion生成的图像质量如何?

A:DistriFusion在加速图像生成的同时,确保生成图像的高质量。 - Q:DistriFusion适用于哪些扩散模型?

A:DistriFusion适用于多种现有扩散模型,如Stable Diffusion XL。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号