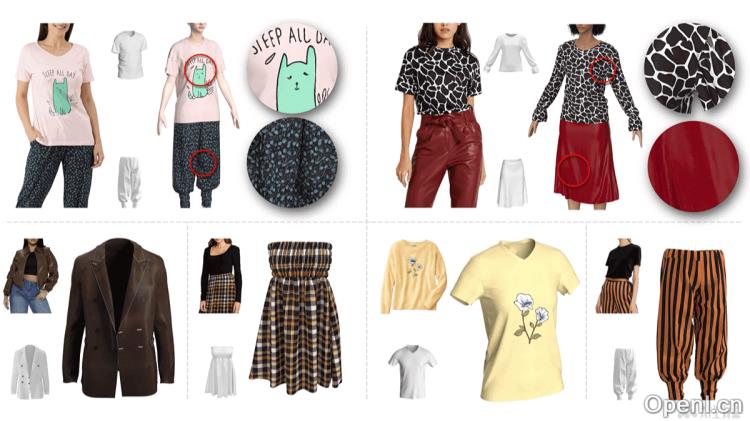

FabricDiffusion是一项由谷歌与卡内基梅隆大合开发的高保真3D服装生成技术,能够将现实中的2D服装图像的纹理与印花高质量地转移至任意形状的3D服装模型上。该技术依托去噪扩散模型和大规模合成数据集,修正输入纹理图像的失真,并生成多种贴图,包括漫反射、粗糙度、法线和金属度,从而实现对3D服装在不同光照条件下的精确重新照明与渲染。

FabricDiffusion是什么

FabricDiffusion是由谷歌和卡内基梅隆大学共同推出的一种先进的3D服装生成技术,旨在将现实生活中的2D服装图像的细腻纹理和独特印花准确地转移到各类3D服装模型上。其核心技术基于去噪扩散模型,结合庞大的合成数据集,有效纠正输入纹理图像的失真,生成包括漫反射、粗糙度、法线以及金属度等多种纹理贴图,展现出卓越的性能与广泛的适应能力。

FabricDiffusion的主要功能

- 高质量纹理转移:自动提取并将2D服装图像的纹理和印花转移至3D服装模型。

- 多种纹理处理:能够处理各类纹理、图案及材料类型。

- 多种纹理贴图生成:支持生成漫反射贴图以及粗糙度、法线和金属度贴图。

- 跨光照条件的渲染:在不同光照条件下实现3D服装的精确重新照明与渲染。

- 零样本泛化能力:在仅使用合成渲染图像进行训练的情况下,成功泛化至现实世界图像。

FabricDiffusion的技术原理

- 去噪扩散模型:利用去噪扩散模型从失真的输入纹理图像中恢复出无失真、可平铺的纹理材料。

- 大规模合成数据集:构建了一个包含超过10万种纺织颜像、3800种PBR材质纹理、7000个印花和22个3D服装网格的大型合成数据集,用于模型训练。

- 纹理图像纠正:基于模型训练,纠正输入纹理图像中的失真,生成与物理基础渲染(PBR)材质生成流程紧密结合的平滑纹理图。

- 特征转移:从单一服装图像中提取并转移纹理图案、材质属性以及详细的印花和标志等多种特征。

- 归一化与可平铺性:生成的纹理图经过归一化处理,能够在服装的UV空间中平铺,完美融入现有的PBR材质估计流程。

- 条件生成:根据输入的服装图像条件生成对应的纹理,实现从2D到3D的高质量纹理转移。

FabricDiffusion的项目地址

FabricDiffusion的应用场景

- 虚拟试衣:在电子商务和时尚零售中,构建虚拟试衣间,让消费者能够在线试穿3D服装,提升购物体验。

- 游戏与娱乐:在游戏开发过程中,迅速生成具有真实纹理的3D服装,增强游戏角色的视觉真实感。

- 虚拟现实(VR)与增强现实(AR):在VR和AR应用中,创造逼真的虚拟环境与角色,提升用户的沉浸感。

- 影视制作:在电影和电视制作中,生成或修改服装纹理,提升特效及服装设计的效率。

- 时尚设计与原型开发:帮助设计师探索新设计与纹理,快速创建服装原型,加速设计迭代。

常见问题

- FabricDiffusion支持哪些类型的服装图像?:FabricDiffusion能够处理多种类型的2D服装图像,包括各种纹理和印花。

- 如何获得FabricDiffusion的技术支持?:用户可以通过项目官网获取相关的支持和文档。

- FabricDiffusion的生成速度如何?:生成速度取决于输入图像的复杂程度和所使用的计算资源。

- 是否可以在不同平台上使用FabricDiffusion?:FabricDiffusion设计为可在多种平台上使用,适合集成到各种应用程序中。

- FabricDiffusion的未来发展方向是什么?:未来将继续优化算法,提高生成质量,并扩展其应用场景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号