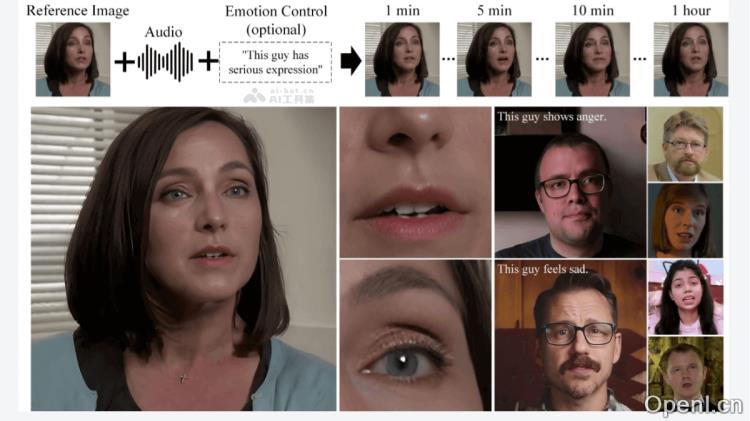

Hallo2是一款由复旦大学、百度公司与合开发的音频驱动视频生成模型。该模型能够结合单张参考图片和数分钟的音频输入,利用可选的文本提示调节肖像的表情,并生成与音频同步的高分辨率4K视频。

Hallo2是什么

Hallo2是由复旦大学、百度公司和学共同研发的前沿音频驱动视频生成模型。它能够将一张参考图片与几分钟的音频输入相结合,并通过可选的文本提示来调节肖像表情,从而生成与音频内容紧密同步的高分辨率4K视频。该模型采用了先进的数据增强技术,如补丁下降和高斯噪声,以增强视频的长期视觉一致性和时间连贯性。Hallo2利用潜在代码的矢量量化和时间对齐技术,生成高质量的视频,并引入语义文本标签作为条件输入,提升动画的可控性和多样性。在多个公开数据集上进行的广泛实验表明,Hallo2在生成长时间、高分辨率以及丰富且可控的内容方面表现出色。

Hallo2的主要功能

- 长时视频生成:支持生成最长可达一小时的视频,有效解决外观漂移和时间伪影的问题。

- 高分辨率输出:实现4K分辨率的肖像视频生成,确保细节清晰可见。

- 音频驱动动画:根据音频输入驱动肖像动画,确保口型和表情的完美同步。

- 文本提示调节:通过文本提示来调节和细化肖像的表情,增加动画的多样性和表现力。

- 数据增强技术:利用补丁下降和高斯噪声增强技术,提高视频的长期视觉一致性和时间连贯性。

Hallo2的技术原理

- 补丁下降技术(Patch-Drop Augmentation):随机丢弃条件帧中的部分图像块,减少前一帧对后续帧外观的影响,保持视频生成中的视觉一致性。

- 高斯噪声增强:在补丁下降的基础上加入高斯噪声,进一步增强模型对参考图像外观的依赖,同时保留信息,减少伪影和失真。

- 向量量化生成对抗网络(VQGAN):通过向量量化潜在代码和时间对齐技术,Hallo2在时间维度上维持连贯性,生成高质量的4K视频。

- 语义文本标签:引入可调的语义文本标签作为条件输入,使模型能够根据文本提示生成特定表情和动作,从而提高生成内容的可控性。

- 跨注意力机制(Cross-Attention Mechanism):模型能够在去噪过程中有效整合条件,例如音频特征和文本嵌入,从而生成与条件输入一致的图像。

Hallo2的项目地址

- 项目官网:fudan-generative-vision.github.io/hallo2

- GitHub仓库:https://github.com/fudan-generative-vision/hallo2

- HuggingFace模型库:https://huggingface.co/fudan-generative-ai/hallo2

- arXiv技术论文:https://arxiv.org/pdf/2410.07718v1

Hallo2的应用场景

- 电影和视频制作:在电影制作中,Hallo2能够生成或增强角色的面部表情和口型,尤其适用于大量虚拟角色或特效的科幻与动画影片。

- 虚拟助手和数字人:在客服、教育和娱乐等领域,Hallo2能够创建真实感极强的虚拟助手或数字人,提供更加自然和吸引人的交互体验。

- 游戏开发:游戏开发者可以利用Hallo2生成高度真实感的角色动画,提升游戏的沉浸感及用户体验。

- 社交媒体和内容创作:内容创作者可借助Hallo2制作动态肖像视频,在社交媒体平台上增加内容的吸引力和互动性。

- 新闻和广播:Hallo2可以生成新闻主播的动画形象,支持多语言播报,快速生成不同语言的口型和表情。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号