VideoCrafter2官网

VideoCrafter2是一款强大的视频处理工具,能够提升视频的视觉质量、动态效果和概念组合,适用于专业视频制作和社交媒体分享。

网站服务:AI大模型,AI视频工具,视频制作,视频处理工具,高质量效果,高质量输出,AI大模型,AI视频工具,视频制作,视频处理工具,高质量效果,高质量输出。

VideoCrafter2简介

VideoCrafter2

什么是”VideoCrafter2″?

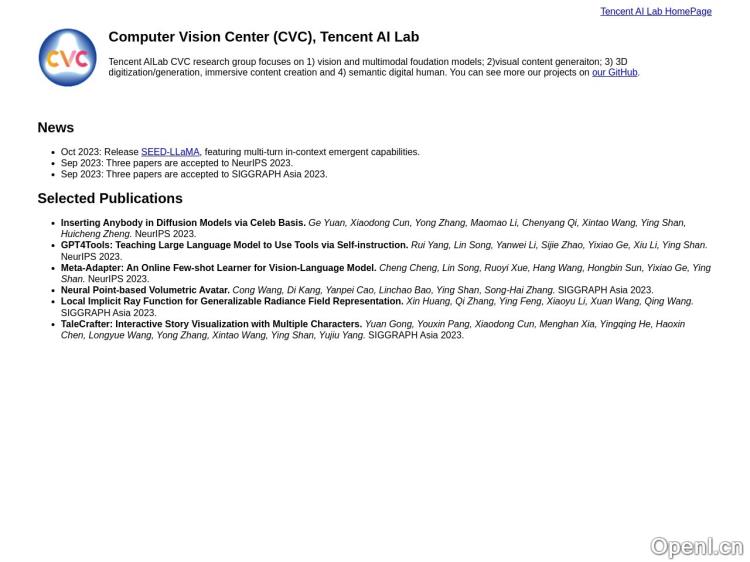

VideoCrafter2是一款强大的视频处理工具,旨在克服数据限制,提供高质量的视频扩散模型。它由腾讯AI实验室开发,经过精心设计和优化,能够显著提升视频的视觉质量、动态效果和概念组合。无论您是专业的视频制作人还是普通用户,VideoCrafter2都能帮助您创造出精美绝伦的影片。

“VideoCrafter2″有哪些功能?

1. 提升视觉质量:VideoCrafter2通过先进的算法和模型,能够将低质量的视频转化为高质量的影片。无论是分辨率、清晰度还是色彩饱和度,都能得到显著提升,让您的视频更加生动逼真。

2. 改善动态效果:VideoCrafter2能够优化视频中的效果,使得物体的移动更加流畅自然。无论是快速的还是缓慢的变化,都能得到更好的表现,让您的视频更具吸引力。

3. 概念组合:VideoCrafter2具备强大的概念组合功能,可以将不同的视频片段、音频和特效进行灵活组合,创造出独特的影片风格。无论是剪辑、合成还是特效处理,都能得到令人满意的结果。

产品特点:

1. 高质量输出:VideoCrafter2采用先进的视频处理算法,能够保证输出视频的高质量。无论是在大屏幕上观看还是在移动设备上播放,都能呈现出清晰、细腻的画面。

2. 简单易用:VideoCrafter2拥有直观友好的用户界面,操作简单方便。无论您是专业的视频制作人还是新手用户,都能轻松上手,快速完成视频处理任务。

3. 快速处理:VideoCrafter2采用高效的算法和并行计算技术,能够快速处理大规模的视频数据。无论是单个视频还是批量处理,都能在短时间内完成,提高工作效率。

应用场景:

1. 专业视频制作:VideoCrafter2适用于专业的视频制作人,可以帮助他们提升视频的质量和效果,创造出令人惊艳的作品。无论是电影、电视剧还是广告片,都能得到满意的结果。

2. 社交媒体分享:VideoCrafter2也适用于普通用户,可以帮助他们将普通的手机拍摄视频转化为高质量的影片,分享到社交媒体平台上。无论是记录生活、分享旅行还是展示才艺,都能吸引更多的关注和赞赏。

“VideoCrafter2″如何使用?

使用VideoCrafter2非常简单。首先,您需要下载并安装VideoCrafter2软件。然后,打开软件并导入您想要处理的视频文件。接下来,根据您的需求选择相应的功能和参数进行设置,例如提升视觉质量、改善动态效果或进行概念组合。最后,点击处理按钮,等待软件完成处理即可。处理完成后,您可以预览和保存处理后的视频文件,也可以进行进一步的编辑和分享。无论您是专业的视频制作人还是普通用户,都能轻松使用VideoCrafter2,创造出令人满意的影片。

VideoCrafter2官网入口网址

https://ailab-cvc.github.io/videocrafter2

OpenI小编发现VideoCrafter2网站非常受用户欢迎,请访问VideoCrafter2网址入口试用。

数据评估

本站OpenI提供的VideoCrafter2都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2024年 4月 17日 下午8:46收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号