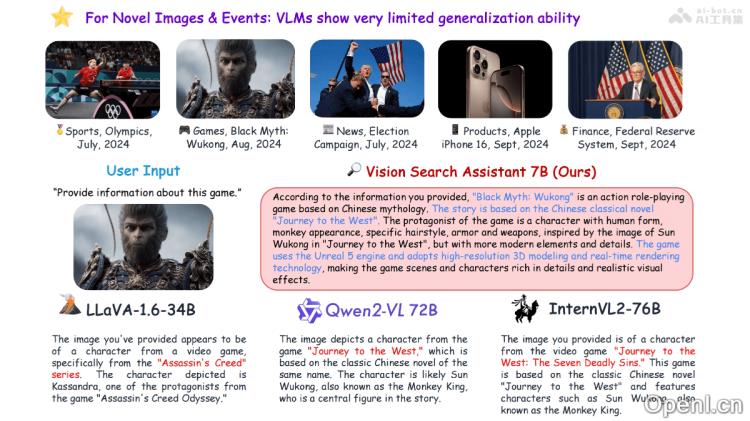

Vision Search Assistant(VSA)是一款创新的框架,通过结合视觉语言模型(VLMs)与网络代理,显著提高了模型对未知视觉内容的解析能力。该工具利用互联网检索,能够处理和解答关于未见图像的相关问题,展现出在开放集和封闭集问答测试中的卓越表现,超越了包括LLaVA-1.6-34B、Qwen2-VL-72B和InternVL2-76B等多个同类模型。VSA可广泛应用于现有的VLMs,增强其对新图像和的处理能力。

Vision Search Assistant是什么

Vision Search Assistant(VSA)是一种前沿技术框架,它将视觉语言模型(VLMs)与网络代理结合在一起,以提升模型理解未知视觉内容的能力。通过互联网检索,VSA能够有效处理并回答关于未见图像的问题。在开放集和封闭集问答测试中,VSA的表现远超其他模型,如LLaVA-1.6-34B、Qwen2-VL-72B和InternVL2-76B。此工具适用于各类现有VLMs,能够显著增强其处理新视觉内容和的能力。

主要功能

- 视觉内容描述:识别图像中的重要对象,并生成相关的描述,整体考虑对象之间的关联性,这一过程被称为相关表述(Correlated Formulation)。

- 网络知识检索:利用一种称为“Chain of Search”的迭代算法,生成多个子问题,通过网络代理搜索相关信息,以获取与用户提问和图像内容相关的知识。

- 协同生成:结合原始图像、用户问题、相关表述及通过网络搜索获取的信息,利用VLM生成最终答案。

- 多模态搜索引擎:将任意VLM转换为能够理解和回应视觉内容的多模态自动搜索引擎。

- 实时信息获取:通过网络代理的实时信息访问能力,VLM能够获取最新的网络数据,从而提高回答的准确性。

- 开放世界检索增强生成:基于互联网检索,增强VLMs处理新视觉内容的能力,使其能够回答关于未见过的图像或新概念的问题。

技术原理

- 视觉内容识别与描述:通过VLM对输入图像进行分析,识别出图像中的关键对象,并生成描述文本。

- 相关性分析:为单个对象生成描述,并分析对象之间的相关性,形成综合考虑这些关系的文本表示,即相关表述。

- 子问题生成:基于用户提问和相关表述,VSA利用大型语言模型(LLM)生成一系列子问题,指导搜索过程,找到更具体的信息。

- 网络搜索与知识整合:依托网络代理执行子问题搜索,分析搜索引擎返回的网页,提取并总结相关信息,形成网络知识。

- 迭代搜索过程:运用“Chain of Search”算法,通过迭代过程逐步细化搜索,获取更加丰富和准确的网络知识。

项目地址

- 项目官网:cnzzx.github.io/VSA

- GitHub仓库:https://github.com/cnzzx/VSA

- arXiv技术论文:https://arxiv.org/pdf/2410.21220

应用场景

- 图像识别与搜索:用户可以上传图片,识别其中的内容并提供相关信息,例如识别历史人物、地标、动植物种类等。

- 新闻分析:分析新闻图片,提供的背景、参与者信息及影响,帮助用户快速了解新闻的全貌。

- 教育与学习:在教育领域中,辅助学习,例如解释科学概念、历史,或提供语言学习中的视觉支持。

- 电子商务:在电商平台,基于图像搜索帮助用户找到所需商品,或提供商品的详细信息和评价。

- 旅游规划:用户上传旅游目的地的图片,获取景点介绍、旅游攻略及文化背景等信息,以辅助用户规划行程。

常见问题

- VSA如何提升图像理解能力?:VSA通过结合视觉语言模型与网络代理,利用互联网检索,能够针对未知图像进行有效的分析与回答。

- 使用VSA需要哪些技术要求?:用户只需具备基本的互联网访问能力,无需复杂的技术背景即可使用此工具。

- VSA支持哪些类型的图像?:VSA能够处理各种类型的图像,包括但不限于人物、风景、物品等。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号