AIGC动态欢迎阅读

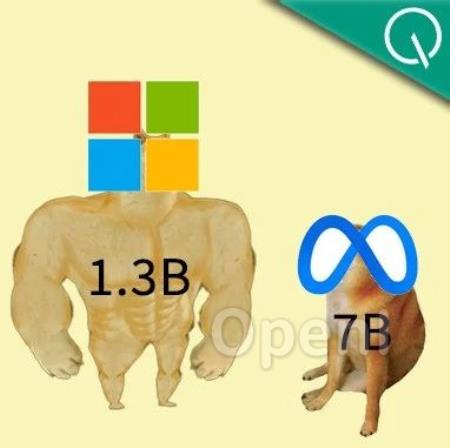

原标题:1.3>7?微软新模型“以小博大”战胜Llama2,网友:用Benchmark训练的吧?

文章来源:量子位

内容字数:4463字

内容摘要:克雷西 发自 凹非寺量子位 | 公众号 QbitAI一个参数量只有1.3B的大模型,为何引发了全网热议?原来虽然参数量不大,但效果已经超过了拥有7B参数的Llama2。这个“四两拨千斤”的模型,是来自微软最新的研究成果,核心在于只使用少量高质数据。微软这次发布的开源模型叫phi-1.5,在只支持代码的1.0版本之上加入了一般场景对话。与一众卷参数量的模型相比,phi可以说是“剑走偏锋”,力求把“大…

原文链接:点此阅读原文:1.3>7?微软新模型“以小博大”战胜Llama2,网友:用Benchmark训练的吧?

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号