AIGC动态欢迎阅读

原标题:北大最新多模态大模型开源:在混合数据集上训练,无需修改直接用到图像视频任务

文章来源:量子位

内容字数:5682字

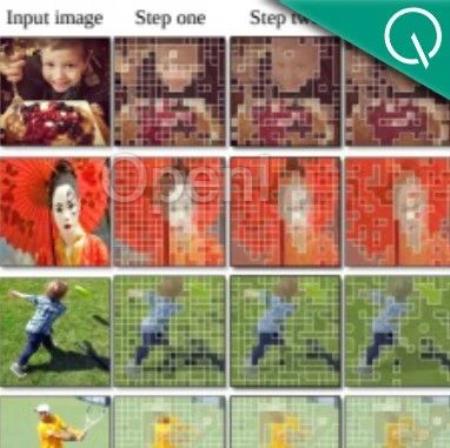

内容摘要:一个北大投稿 发送至 凹非寺量子位 | 公众号 QbitAI训完130亿参数通用视觉语言大模型,只需3天!北大和中山大学团队又出招了——在最新研究中,研究团队提出了一种构建统一的图片和视频表征的框架。利用这种框架,可以大大减少VLM(视觉语言大模型)在训练和推理过程中的开销。具体而言,团队按照提出的新框架,训练了一个新的VLM:Chat-UniVi。Chat-UniVi能在混合图片和视频数据的情况下进行训练,并同时处理图片任务和视频理解任务。以此为基础,Chat-UniVi在图片及视频上的17个基准上,都表现得还不错。现在,项目已经在GitHub和抱抱脸上开源。更多关于新方法和Chat-UniVi的详细信息,我们一起进一步来看看~Chat-UniVi是什么?了解基础信息后,我们详细地聊聊Chat-UniVi究竟是什么——简单来说,Chat-UniVi是一个统一的多模态大型语言模型,可以同时…

原文链接:点此阅读原文:北大最新多模态大模型开源:在混合数据集上训练,无需修改直接用到图像视频任务

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号