AIGC动态欢迎阅读

原标题:一条磁力链接席卷AI圈,87GB种子直接开源8x7B MoE模型

文章来源:机器之心

内容字数:3764字

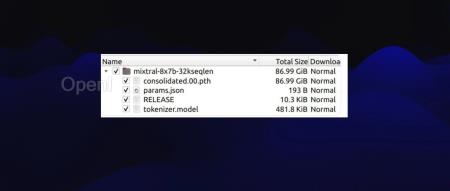

内容摘要:机器之心报道机器之心编辑部「高端」的开源,往往采用最朴素的发布方式。昨天,Mistral AI 在 X 平台甩出一条磁力链接,宣布了新的开源动作。没有长篇官方博客,没有刻意加速的 Demo,这家公司算是当下大模型领域的「一股清流」。打开一看,发现是接近 87 GB 的种子:参数配置什么样?很多人放弃了周末,第一时间下载运行起来。看上去,Mistral 8x7B 使用了与 GPT-4 非常相似的架构,但是「缩小版」:8 个专家总数,而不是 16 名(减少一半)每个专家为 7B 参数,而不是 166B(减少 24 倍)42B 总参数(估计)而不是 1.8T(减少 42 倍)与原始 GPT-4 相同的 32K 上下文在发布后 24 小时内,已经有开发者做出了在线体验网站:https://replicate.com/nateraw/mixtral-8x7b-32kseqlen有研究者称:「闭源大模…

原文链接:点此阅读原文:一条磁力链接席卷AI圈,87GB种子直接开源8x7B MoE模型

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号