AIGC动态欢迎阅读

原标题:万字详解提示学习(Prompt Learning )和微调 (Prompt Tuning)

关键字:任务,提示,模型,解读,显著特征

文章来源:算法邦

内容字数:16063字

内容摘要:

本文转载自公众号:青稞AI,原作者:爱吃牛油果的璐璐,如需转载请与原作者联系。1、前言

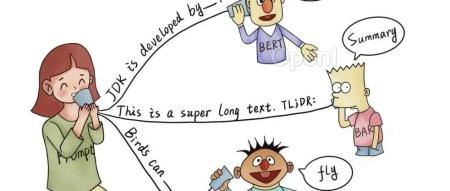

Self-Attention 和 Transformer 自从问世就成为了自然语言处理领域的新星。得益于全局的注意力机制和并行化的训练,基于 Transformer 的自然语言模型能够方便的编码长距离依赖关系,同时在大规模自然语言数据集上并行训练成为可能。但由于自然语言任务种类繁多,且任务之间的差别不太大,所以为每个任务单独微调一份大模型很不划算。

在 CV 中,不同的图像识别任务往往也需要微调整个大模型,也显得不够经济。Prompt Learning 的提出给这个问题提供了一个很好的方向。

本文主要根据综述文章《Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing》[1] 以及相关论文整理而来,在此基础之上,总结了一些现有的对 prompt learning 的相关讨论(如其缺陷,与其他学习方法的比较等)。望承前人之高屋建瓴,增添后之砖瓦。希望大

原文链接:万字详解提示学习(Prompt Learning )和微调 (Prompt Tuning)

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号