AIGC动态欢迎阅读

原标题:一句话精准视频片段定位!清华新方法拿下SOTA|已开源

关键字:音频,视觉,分支,文本,视频

文章来源:量子位

内容字数:5892字

内容摘要:

陈厚伦 投稿量子位 | 公众号 QbitAI只需一句话描述,就能在一大段视频中定位到对应片段!

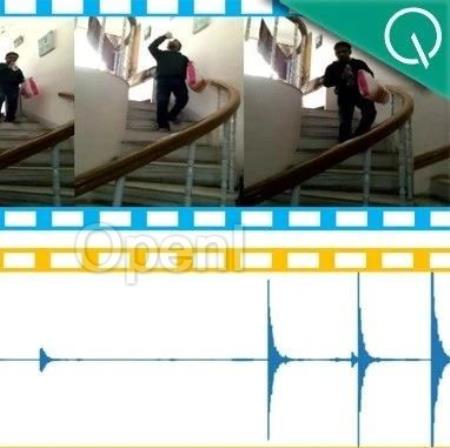

比如描述“一个人一边下楼梯一边喝水”,通过视频画面和脚步声的匹配,新方法一下子就能揪出对应起止时间戳:

就连“大笑”这种语义难理解型的,也能准确定位:

方法名为自适应双分支促进网络(ADPN),由清华大学研究团队提出。

具体来说,ADPN是用来完成一个叫做视频片段定位(Temporal Sentence Grounding,TSG)的视觉-语言跨模态任务,也就是根据查询文本从视频中定位到相关片段。

ADPN的特点在于能够高效利用视频中视觉和音频模态的一致性与互补性来增强视频片段定位性能。

相较其他利用音频的TSG工作PMI-LOC、UMT,ADPN方法从音频模态获取了更显著地性能提升,多项测试拿下新SOTA。

目前该工作已经被ACM Multimedia 2023接收,且已完全开源。

一起来看看ADPN究竟是个啥~

一句话定位视频片段视频片段定位(Temporal Sentence Grounding,TSG)是一项重要的视觉-语言跨模态任务。

它的目的是根据自然语言查询,在一个未剪辑的视频

原文链接:一句话精准视频片段定位!清华新方法拿下SOTA|已开源

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号