AIGC动态欢迎阅读

原标题:总结!大模型微调(Tuning)的常见方法

关键字:模型,参数,任务,方法,知乎

文章来源:算法邦

内容字数:12945字

内容摘要:

直播预告 | 1月17日晚7点,「多模态大模型线上闭门会」正式开讲!阿里巴巴通义实验室 NLP 高级算法专家严明参与出品,携手刘兆洋、李彦玮、文束三位青年学者,共同探讨多模态大模型的发展与应用,欢迎报名。本文转载自公众号:青稞AI,原作者:爱吃牛油果的璐璐@知乎,如需转载请与原作者联系。前言:微调是指调整大型语言模型(LLM)的参数以适应特定任务的过程。这是通过在与任务相关的数据集上训练模型来完成的。所需的微调量取决于任务的复杂性和数据集的大小。在深度学习中,微调是一种重要的技术,用于改进预训练模型的性能。除了微调ChatGPT之外,还有许多其他预训练模型可以进行微调。

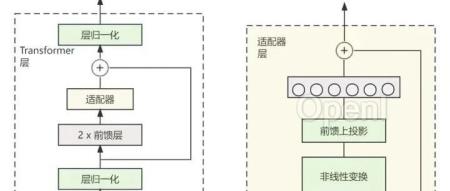

01PEFT是什么PEFT(Parameter-Efficient Fine-Tuning)是hugging face开源的一个参数高效微调大模型的工具,里面集成了4种微调大模型的方法,可以通过微调少量参数就达到接近微调全量参数的效果,使得在GPU资源不足的情况下也可以微调大模型。02微调方法微调可以分为全微调和重用两个方法:

全微调(Full Fine-tuning):全微调是指对整个预训练模型进行微调,包括所有的模

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号