AIGC动态欢迎阅读

原标题:三行代码无损加速40%,尤洋团队AI训练加速器入选ICLR Oral论文

关键字:样本,梯度,方式,损失,轮次

文章来源:量子位

内容字数:3696字

内容摘要:

克雷西 发自 凹非寺量子位 | 公众号 QbitAI用剪枝的方式加速AI训练,也能实现无损操作了,只要三行代码就能完成!

今年的深度学习顶会ICLR上,新加坡国立大学尤洋教授团队的一项成果被收录为Oral论文。

利用这项技术,可以在没有损失的前提下,节约最高40%的训练成本。

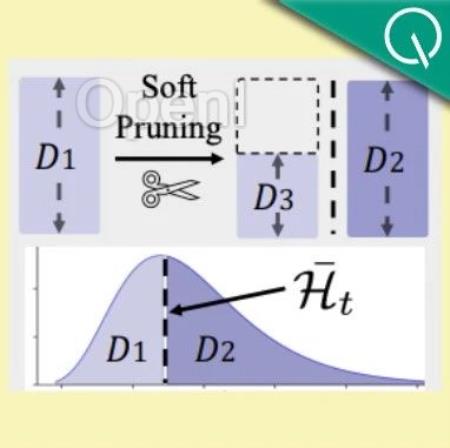

这项成果叫做InfoBatch,采用的依然是修剪样本的加速方式。

但通过动态调整剪枝的内容,InfoBatch解决了加速带来的训练损失问题。

而且即插即用,不受架构限制,CNN网络和Transformer模型都能优化。

目前,该算法已经受到了多家云计算公司的关注。

那么,InfoBatch能实现怎样的加速效果呢?

无损降低40%训练成本研究团队在多个数据集上开展的实验。都验证了InfoBatch的有效性。

这些实验涵盖的任务包括图像的分类、分割和生成,以及语言模型的指令微调等。

在图像分类任务上,研究团队使用CIFAR10和CIFAR100数据集训练了ResNet-18。

结果在30%、50%和70%的剪枝率下,InfoBatch的准确率都超越了随机剪枝和其他baseline方法,而且在30%的剪枝率下没有任何精

原文链接:三行代码无损加速40%,尤洋团队AI训练加速器入选ICLR Oral论文

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号