AIGC动态欢迎阅读

内容摘要:

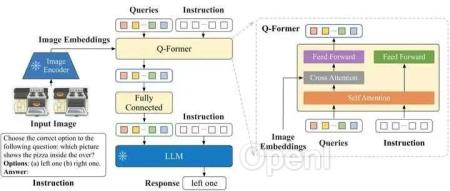

直播预告 | 1月22日晚7点,「自动驾驶新青年讲座」第35讲正式开讲,LMDrive一作、香港中文大学MMLab在读博士邵昊将主讲《LMDrive:大语言模型加持的闭环端到端自动驾驶框架》,欢迎扫名~本文转载自公众号:青稞AI,原作者:friedrichor@知乎,如需转载请与原作者联系。从最近一年很热门的大型多模态模型(或者说多模态大语言模型)简单谈一下是怎么对齐不同模态的,如何使大语言模型(Large Language Models, LLM)能够处理视觉任务。

去年11月ChatGPT的发布让大家都认识到了大模型的实力。之前大家大部分应该还在做基于预训练模型来添加些模型模块(如cross attention等)在下游任务上微调或者做multi-task,也有做prompt的,大部分人的注意力还不在大模型上(这里我写的预训练模型模型还是区别于大模型的,类似于BERT、Vision Transformer这种的)。可能是因为GPT-3在其论文中的表现并不那么引人瞩目,在下游任务上的性能并不如在相应任务数据集上微调过的预训练模型,并且模型不开源,大家也没法来探索大模型的潜在能力,

原文链接:多模态训练,怎么对齐不同模态?

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号