AIGC动态欢迎阅读

原标题:Llama2击败GPT-4 !| Meta提出自奖励语言模型,实现Llama2超进化!

关键字:模型,研究人员,数据,指令,自我

文章来源:算法邦

内容字数:6729字

内容摘要:

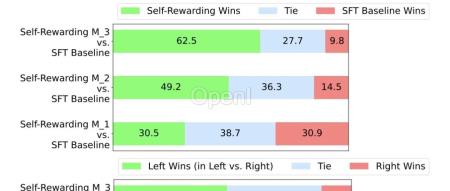

本文转载自公众号:新智元,编辑:桃子,如需转载请与该公众号联系。【导读】AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。Llama 2-70B一夜之间打败GPT-4,让整个AI社区为之震惊!甚至,在AlpacaEval 2.0排行榜中,微调后的模型胜率完全碾压Claude 2、Gemini Pro等模型。Meta和NYU研究团队究竟提出了什么秘制配方,才能让Llama 2-70B超强进化?

正如论文题目所言——「自激励语言模型」,模型生成训练数据,并评估这些数据的质量,然后用这些数据来自己训练自己。

简单来说,最新方法可以让LLM在迭代训练过程中不断自我改进。论文地址:

https://arxiv.org/pdf/2401.10020.pdf

LeCun也转赞了自家实验室的研究。RLAIF已经不是新鲜事了,之前包括Anthropic,谷歌都推出过自己的「AI训AI」的技术,那么Meta的这项工作和之前的几家的RLAIF区别在哪里呢?

我们先来了解一下Meta的自奖

原文链接:Llama2击败GPT-4 !| Meta提出自奖励语言模型,实现Llama2超进化!

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号