AIGC动态欢迎阅读

原标题:GPT-4V只能排第二!华科大等发布多模态大模型新基准:五大任务14个模型全面测评

关键字:数据,文本,模型,本文,语义

文章来源:新智元

内容字数:13336字

内容摘要:

新智元报道编辑:LRS 好困

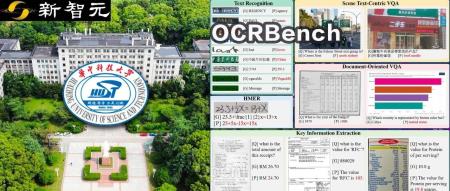

【新智元导读】华中科技大合华南理工大学、北京科技大学等机构的研究人员对14个主流多模态大模型进行了全面测评,涵盖5个任务,27个数据集。近期,多模态大模型(LMMs)在视觉语言任务方面展示了令人印象深刻的能力。然而,由于多模态大模型的回答具有开放性,如何准确评估多模态大模型各个方面的性能成为一个迫切需要解决的问题。

目前,一些方法采用GPT对答案进行评分,但存在着不准确和主观性的问题。另外一些方法则通过判断题和多项选择题来评估多模态大模型的能力。

然而,判断题和选择题只是在一系列参中选择最佳答案,不能准确反映多模态大模型完整识别图像中文本的能力,目前还缺乏针对多模态大模型光学字符识别(OCR)能力的专门评测基准。

近期,华中科技大学白翔团队联合华南理工大学、北京科技大学、中科院和微软研究院的研究人员对多模态大模型的OCR能力进行了深入的研究。

并在27个公有数据集和2个生成的无语义和对比的有语义的数据集上对文字识别、场景文本VQA、文档VQA、关键信息抽取和手写数学表达式识别这五个任务上进行了广泛的实验。论文链接:https://arxiv.o

原文链接:GPT-4V只能排第二!华科大等发布多模态大模型新基准:五大任务14个模型全面测评

联系作者

文章来源:新智元

作者微信:AI_era

作者简介:智能+中国主平台,致力于推动中国从互联网+迈向智能+新纪元。重点关注人工智能、机器人等前沿领域发展,关注人机融合、人工智能和机器人对人类社会与文明进化的影响,领航中国新智能时代。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号