AIGC动态欢迎阅读

原标题:音频秒生全身虚拟人像,AI完美驱动面部肢体动作!UC伯克利Meta提出Audio2Photoreal

关键字:模型,音频,手势,身体,动作

文章来源:新智元

内容字数:5832字

内容摘要:

新智元报道编辑:拉燕

【新智元导读】最近,来自Meta和UC伯克利的研究人员,发布了一种最新的音频到人像模型。操作简单,输出极致逼真。就在最近,Meta和UC伯克利联合提出了一种全新的虚拟人物形象生成的方法——

直接根据音频生成全身人像,效果不仅逼真,还能模拟出原音频中包含的细节,比如手势、表情、情绪等等。

论文地址:https://arxiv.org/abs/2401.01885

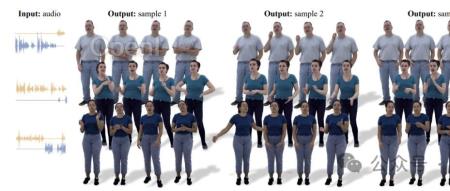

话不多说,直接上图。

可以看到,人像刷地一下就出来了,十分逼真。

而且从上面的文字对话可以看到,就是在讲可以用音频生成虚拟人像这件事。讲者的手势动作真的像是在做讲解。

音频到Avatar,一步!这个系统不光可以生成全身逼真的形象,人像还会根据二人互动的对话动态做出手势。

给定语音音频后,音频会为一个人输出多种可能的手势动作,包括面部、身体和双手等部位。

Meta表示,方法的关键就在于将矢量量化带来的样本多样性优势与通过扩散获得的高频细节相结合,从而生成更具动态和表现力的动作。

研究团队使用了高度逼真的人像,将生成的可视化。这些头像可以表达手势中的关键细微差别(如讥笑和傻笑)。

为了促进这一研究方向,M

原文链接:音频秒生全身虚拟人像,AI完美驱动面部肢体动作!UC伯克利Meta提出Audio2Photoreal

联系作者

文章来源:新智元

作者微信:AI_era

作者简介:智能+中国主平台,致力于推动中国从互联网+迈向智能+新纪元。重点关注人工智能、机器人等前沿领域发展,关注人机融合、人工智能和机器人对人类社会与文明进化的影响,领航中国新智能时代。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号