AIGC动态欢迎阅读

原标题:ICLR 2024 Spotlight|厦门大学、Intel、大疆联合出品,从网络视频中学习零样本图像匹配大模型

关键字:模型,视频,性能,图像,数据

文章来源:机器之心

内容字数:5706字

内容摘要:

机器之心专栏

机器之心编辑部图像匹配是计算机视觉的一项基础任务,其目标在于估计两张图像之间的像素对应关系。图像匹配是众多视觉应用如三维重建、视觉定位和神经渲染(neural rendering)等的基础和前置步骤,其精确度和效率对于后续处理十分重要。

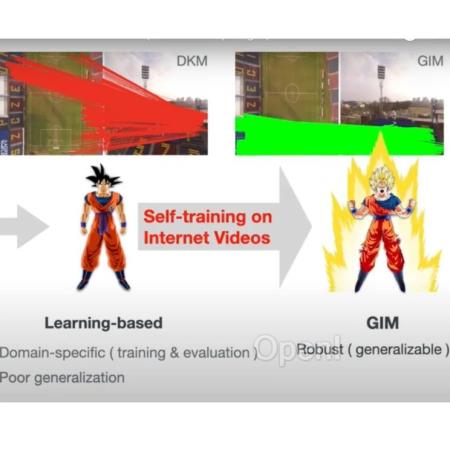

传统算法(SIFT)在面临长基线或极端天气等复杂场景时,其匹配的准确度和密度往往有限。为了解决这些问题,近年来,基于深度学习的匹配模型逐渐流行。然而,由于缺乏大规模且多样化的具有真值标签的训练数据,目前的匹配模型通常是在 ScanNet 和 MegaDepth 上分别训练室内和室外两个模型。这种针对特定场景的训练限制了模型对 zero-shot 场景的泛化,无法扩展至未知场景中。此外,现有的数据构建方法往往依赖于 RGBD 扫描或 SfM+MVS 进行重建,其效率和适用性有限,无法有效地扩展数据并用于模型训练。

为了解决基于深度学习方法泛化性的问题,来自厦门大学、Intel、大疆的研究者们提出了 GIM: Learning Generalizable Image Matcher from Internet Videos。GIM 是第一个可

原文链接:ICLR 2024 Spotlight|厦门大学、Intel、大疆联合出品,从网络视频中学习零样本图像匹配大模型

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号