AIGC动态欢迎阅读

原标题:Meta 联合纽约大学和华盛顿大学提出MetaCLIP,带你揭开CLIP的高质量数据之谜。

关键字:数据,算法,模型,质量,字符串

文章来源:机器之心

内容字数:5068字

内容摘要:

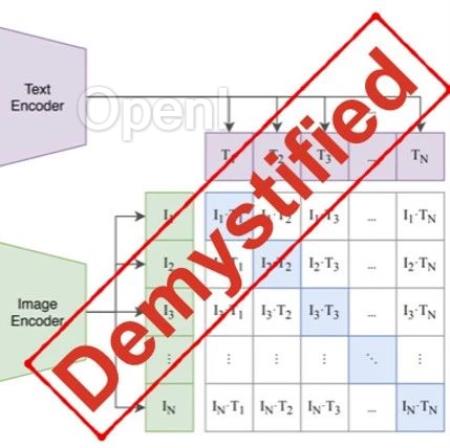

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。自2021年诞生,CLIP已在计算机视觉识别系统和生成模型上得到了广泛的应用和巨大的成功。我们相信CLIP的创新和成功来自其高质量数据(WIT400M),而非模型或者损失函数本身。虽然3年来CLIP有大量的后续研究,但并未有研究通过对CLIP进行严格的消融实验来了解数据、模型和训练的关系。

CLIP原文仅有简短的数据处理描述,而后续工作依靠已经训练好的CLIP来重新过滤数据去训练CLIP(学生)模型。更广泛地说,虽然目前的开源着重强调已训练模型权重的公开,而训练数据以及如何从低质量数据获得高质量数据的技巧的公开度却往往并不那么高。

本文带你揭开CLIP的数据质量之谜,为开源社区带来元数据导向的CLIP预训练(MetaCLIP)。原文链接:https://ar

原文链接:Meta 联合纽约大学和华盛顿大学提出MetaCLIP,带你揭开CLIP的高质量数据之谜。

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号