AIGC动态欢迎阅读

原标题:用基础模型指导特征传播,首个泛化型图像匹配器OmniGlue搞定未见过域

关键字:图像,研究者,关键,特征,模型

文章来源:机器之心

内容字数:5329字

内容摘要:

机器之心报道

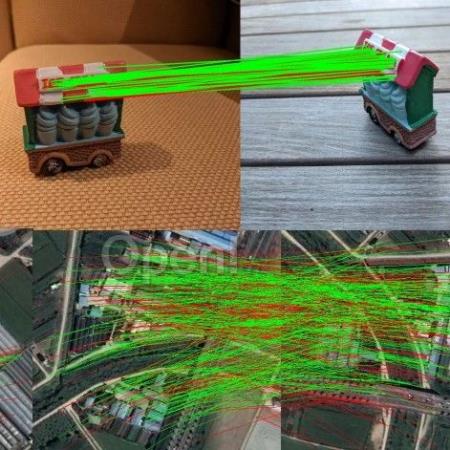

编辑:杜伟第一个以「泛化」能力为核心设计原则的可学习图像匹配器来了!对于想要获取两张图像之间的细粒度视觉对应关系而言,局部图像特征匹配技术是高不错的 xuanz,对于实现准确的相机姿态估计和 3D 重建至关重要。过去十年见证了从手工制作到基于学习的图像特征的演变。

最近,研究社区又提出了新颖的可学习图像匹配器,在传统基准上实现了性能的不断改进。尽管已经取得了长足的进步,但这些进展忽略了一个重要方面:图像匹配模型的泛化能力。

如今,大多数局部特征匹配研究都集中在具有丰富训练数据的特定视觉领域(如室外和室内场景),这就导致了模型高度专用于训练领域。遗憾的是,这些方法的性能在域外数据(如以对象为中心或空中捕获)上通常急剧下降,在某些情况下甚至可能并不比传统方法好很多。

因此,传统的域无关技术(如 SIFT)仍被广泛用于获取下游应用的姿态。并且由于收集高质量注释的成本很高,在每个图像域都有丰富的训练数据是不现实的,就像其他一些视觉任务一样。因此,社区应该专注于开发架构改进,使得可学习的匹配方法具有泛化能力。

近日,受上述观察的启发,德克萨斯大学奥斯汀分校和谷歌研究院的研究者联合提

原文链接:用基础模型指导特征传播,首个泛化型图像匹配器OmniGlue搞定未见过域

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号