AIGC动态欢迎阅读

内容摘要:

直播预告 | 6月6日晚7点,「智猩猩AI新青年讲座」第238讲正式开讲,香港大学CVMI Lab在读博士 杨霁晗将直播讲解《V-IRL:根植于真实世界的AI Agents》,欢迎扫名导读本文来自知乎,作者为Dreamweaver。本文只做学术/技术分享,如有侵权,联系删文。

本文回顾了多模态LLM (视觉-语言模型) 近一年来的模型架构演进,对其中有代表性的工作进行了精炼总结。

原文链接:

https://zhuanlan.zhihu.com/p/693885420首先,推荐一篇启发我很多的综述和对应的项目地址A Survey on Multimodal Large Language Models

arxiv.org/abs/2306.13549Awesome-Multimodal-Large-Language-Models

github.com/BradyFU/Awesome-Multimodal-Large-Language-Models

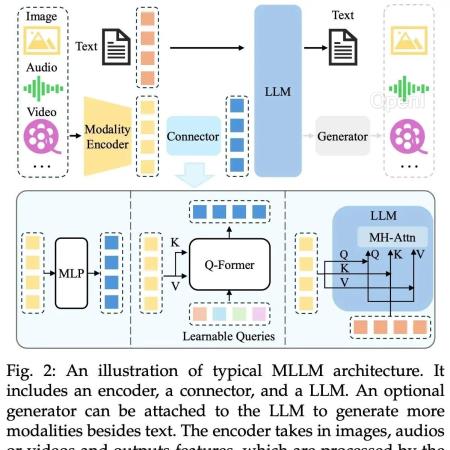

这篇综述一张图总结了多模态LLM的典型架构:

BLIP【2022.01发布】https://arxiv.org/abs/2201.1208

原文链接:多模态视觉-语言大模型的架构演进

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,聚焦生成式AI,重点关注模型与应用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号