AIGC动态欢迎阅读

原标题:全华人团队推出多模态大模型新基准,GPT-4o准确率仅为65.5%,所有模型最易犯感知错误

关键字:任务,模型,数据,研究人员,视觉

文章来源:量子位

内容字数:0字

内容摘要:

王家豪 投稿自 凹非寺量子位 | 公众号 QbitAIGPT-4o再次掀起多模态大模型的浪潮。

如果他们能以近似人类的熟练程度,在不同领域执行广泛的任务,这对许多领域带来性进展。

因而,构建一个全面的评估基准测试就显得格外重要。然而评估大型视觉语言模型能力的进程显著落后于它们自身的发展。

来自上海AI Lab、香港大学、上海交大、浙江大学等多家机构提出了 MMT-Bench。

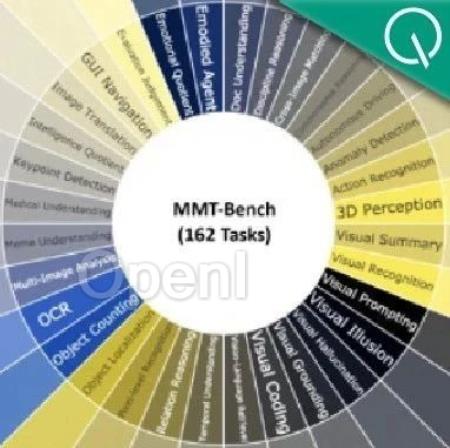

这是一个全方位的多模态基准测试,旨在全面评估大型视觉语言模型(LVLMs)在多模态多任务理解方面的表现。

研究团队还对当前几个代表的视觉大模型进行了能力评估,结果发现感知错误、推理错误是所有模型最常见的两大错误。

多模态多任务AGI基准测试MMT-BenchMMT-Bench的广度体现在三个方面。

首先,MMT-Bench数据经过精心设计,包含32K个多选视觉语言问题,涵盖了32个核心元任务和162个子任务,这比此前的评测数据集MMBench大8.1倍。

其次,MMT-Bench包含了13种图像类型,如自然场景、合成图像、深度图、富文本图像、绘画、屏幕截图、点云、医学图像等。这样的图片多样性要求模型能够解释理

原文链接:全华人团队推出多模态大模型新基准,GPT-4o准确率仅为65.5%,所有模型最易犯感知错误

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号