AIGC动态欢迎阅读

原标题:一步文生图大模型还能“更小更快”,MixDQ量化方法无损“瘦身”扩散模型3倍,提速1.5倍

关键字:模型,方案,显存,图像,方法

文章来源:大数据文摘

内容字数:0字

内容摘要:

大数据文摘授权转载自将门创投

作者:赵天辰

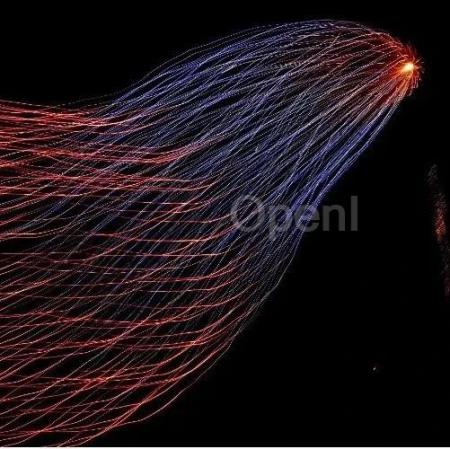

我们提出了MixDQ,一种面向少步扩散模型的混合比特量化方案。

MixDQ分析定位了“少步扩散模型量化”的独特问题,并提出针对性解决方案。

针对少步生成模型,在现有量化方案在W8A8损失严重的情况下,MixDQ在能够实现多方面指标(图像质量,文图吻合,人为偏好)无损的W8A8量化,W4A8无明显视觉损失。

我们实现了高效的INT8 GPU算子,以实现实际的显存与延迟优化,并将模型开源为Huggingface Pipeline,通过几行代码即可调用。论文标题:

MixDQ: Memory-Efficient Few-Step Text-to-Image Diffusion Models with Metric-Decoupled Mixed Precision Quantization

论文链接:

https://arxiv.org/abs/2405.17873

Project page:

https://a-suozhang.xyz/mixdq.github.io/

Huggingface Pipeline:

https://huggingf

原文链接:一步文生图大模型还能“更小更快”,MixDQ量化方法无损“瘦身”扩散模型3倍,提速1.5倍

联系作者

文章来源:大数据文摘

作者微信:BigDataDigest

作者简介:普及数据思维,传播数据文化

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号