AIGC动态欢迎阅读

原标题:kimi chat大模型的200万长度无损上下文可能是如何做到的?

关键字:报告,知乎,侵权,序列,机器

文章来源:算法邦

内容字数:0字

内容摘要:

7月11日19点,「智猩猩自动驾驶新青年讲座」第36讲将开讲,主讲理想汽车最新成果:基于MLLM的闭环规划智能体PlanAgent,由理想汽车实习研究员、中国科学院自动化研究所在读博士郑宇鹏主讲,主题为《面向自动驾驶的3D密集描述与闭环规划智能体》。扫码预约视频号直播~导读本文来自知乎,作者为方佳瑞。出于学术/技术分享进行转载,如有侵权,联系删文。

本文是作者对知乎问题“kimi chat大模型的200万长度无损上下文可能是如何做到的?”的回答,以及阅读Mooncake技术报告的学习笔记。

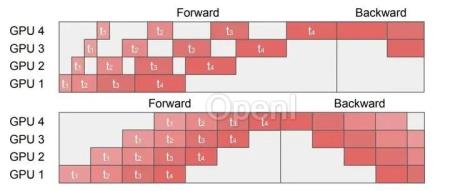

原文链接:https://www.zhihu.com/question/649192998/answer/3546745976这周,清华和Moonshot发了一个技术报告,介绍Kimi背后的LLM服务系统Mooncake,它采用分离式设计,将Prefill和Decode两阶段解耦,构建了一个全局KVCache Pool,实现以Cache为中心的调度。

Moonshot作为MaaS头部厂商,以其过硬的技术产品实力和明星的团队阵容闻名于世。和其他大模型公司不一样,他们很少发技术报告或对外做技术分享。这次

原文链接:kimi chat大模型的200万长度无损上下文可能是如何做到的?

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,聚焦生成式AI,重点关注模型与应用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号