AIGC动态欢迎阅读

原标题:【综述专栏】大型视觉语言模型攻击综述:资源、进展与未来趋势!

关键字:模型,方法,数据,攻击者,报告

文章来源:人工智能学家

内容字数:0字

内容摘要:

来源:人工智能前沿讲习

在科学研究中,从方上来讲,都应“先见森林,再见树木”。当前,人工智能学术研究方兴未艾,技术迅猛发展,可谓万木争荣,日新月异。对于AI从业者来说,在广袤的知识森林中,系统梳理脉络,才能更好地把握趋势。为此,我们精选国内外优秀的综述文章,开辟“综述专栏”,敬请关注。链接:https://arxiv.org/abs/2407.07403

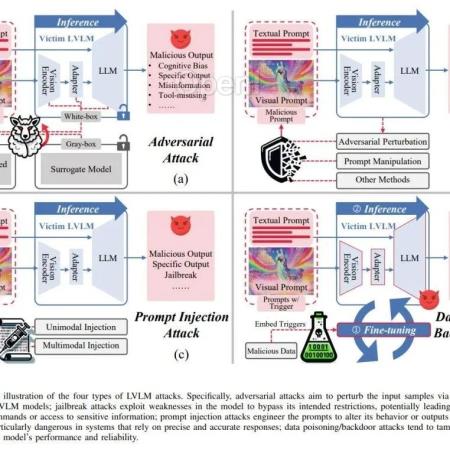

近年来,随着大型模型的显著发展,大型视觉-语言模型(LVLMs)在各种多模态理解和推理任务中展示了卓越的能力。相比于传统的大型语言模型(LLMs),由于更接近多资源的现实世界应用和多模态处理的复杂性,LVLMs 展示了巨大的潜力和挑战。然而,LVLMs 的脆弱性相对较少被探索,在日常使用中可能存在潜在的安全风险。在本文中,我们对现有的各种 LVLM 攻击形式进行了全面的回顾。具体来说,我们首先介绍了针对 LVLMs 攻击的背景,包括攻击的初步知识、攻击的挑战和攻击资源。然后,我们系统地回顾了 LVLM 攻击方法的发展,如操纵模型输出的对抗攻击,利用模型漏洞进行未授权操作的越狱攻击,设计提示类型和模式的提示注入攻击,以及影响模型训练

原文链接:【综述专栏】大型视觉语言模型攻击综述:资源、进展与未来趋势!

联系作者

文章来源:人工智能学家

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号