AIGC动态欢迎阅读

原标题:大模型训练及推理经典必读:FP8的what,why,how及其带来的机会?

关键字:精度,模型,解读,侵权,性能

文章来源:智猩猩AGI

内容字数:0字

内容摘要:

生成式AI时代最火AI芯片峰会下月来袭!9月6-7日,智猩猩发起主办的2024全球AI芯片峰会将在北京盛大举行。峰会设有开幕式、数据中心AI芯片专场、边缘/端侧AI芯片专场、智算集群技术论坛等7大板块。50+位AI芯片/Chiplet/RISC-V企业大咖将参与主题演讲、高端对话和圆桌Panel。完整议程已公布。扫名或购票~文章转载自公众号:老刘说NLP,本文只做学术/技术分享,如有侵权,联系删文。

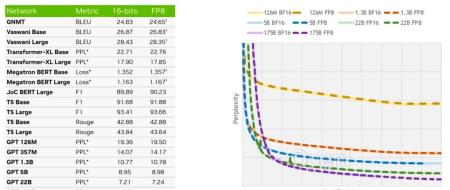

今天,我们来谈谈关于大模型训练推理的话题,来讲讲NVIDIA提出的FP8。

我们可以深刻感受到,在当前大模型大行其道的背景下,多种不同参数量的大语言模型呈现出井喷状态,但其背后实际上与算力强相关,无论是大模型预训练、SFT微调、PPO强化,还是在推理阶段,都涉及到大规模的矩阵运算,且模型的大小和计算复杂性不断增加,对硬件的性能和能效提出了极高要求,在特定算力情况下,如何选择一套合适的精度表示,成为了大家关注的话题。

而与矩阵运算关系最为密切的,是精度的表示,常见的主要有浮点数精度,包括双精度(FP64)、单精度(FP32、TF32)、半精度(FP16、BF16)、8位

原文链接:大模型训练及推理经典必读:FP8的what,why,how及其带来的机会?

联系作者

文章来源:智猩猩AGI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号