AIGC动态欢迎阅读

原标题:OpenAI o1 self-play RL 技术路线推演

关键字:模型,方式,知乎,侵权,能力

文章来源:智猩猩GenAI

内容字数:0字

内容摘要:

导读文章转载自知乎,作者为曹宇,本文对train-time compute和test-time compute相关技术上可能的技术路线进行了推演,在整体思路上还原OpenAI o1的训练及推理时整体技术路径。原文地址:https://zhuanlan.zhihu.com/p/720106482

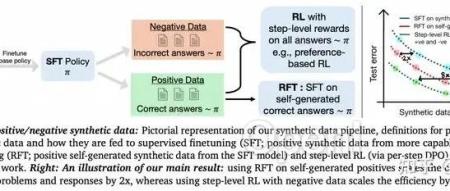

本文只做学术/技术分享,如有侵权,联系删文。OpenAI的self-play RL新模型o1最近交卷,直接引爆了关于对于self-play的讨论。在数理推理领域获得了傲人的成绩,同时提出了train-time compute和test-time compute两个全新的RL scaling law。作为领域博主,在时效性方面肯定卷不过其他营销号了,所以这次准备了大概一万字的内容,彻底深入分析并推演一遍其中的相关技术细节。01o1,而今迈步从头越首先要说一下,o1是一个多模态模型,很多人包括 Jim Fan都忽略了这一点:因此他继续叫做o,作为omni系列是没有任何疑问的。只不过这次发布是过于低调了,很多人都没有注意到这个拉爆了所有其他多模态框架的78.1分。那么这个o1,说明这个技术路线就是一个

原文链接:OpenAI o1 self-play RL 技术路线推演

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号