AIGC动态欢迎阅读

原标题:如何从零训练多模态大模型(预训练方向)

关键字:知乎,侵权,数据,阶段,指令

文章来源:智猩猩GenAI

内容字数:0字

内容摘要:

开讲预约导读原文来自知乎,作者为HelloWorld,标题为《LLaVA(六)训练你自己的多模态模型》。作者详细介绍了如何从零训练LLaVA v1.5多模态模型,包括特征对齐和视觉指令微调两个阶段的训练流程、数据准备、启动脚本及相关注意事项。原文地址:https://zhuanlan.zhihu.com/p/718354385

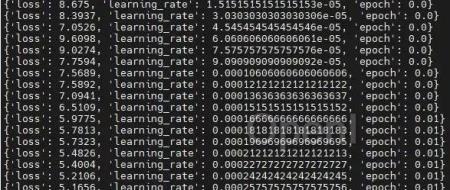

本文只做学术/技术分享,如有侵权,联系删文。本文参考官方教程[1]介绍如何训练 LLaVA v1.5 多模态模型。LLaVA 训练包括特征对齐阶段(feature alignment stage)和视觉指令微调阶段(visual instruction tuning stage),其中特征对齐阶段使用 LAION-CC-SBU 数据集的 558K 子集(记为 LLaVA-Pretrain),目的是训练 MLP connector(或称为 projector),而视觉指令微调阶段使用 GPT-4 生成的 150K 条多模态指令跟随数据和来自学术任务的 515K 条 VQA 数据引导 LLaVA 模型遵从多模态指令。

官方给出的 LLaVA v1.5 使用了 8 个

原文链接:如何从零训练多模态大模型(预训练方向)

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号