AIGC动态欢迎阅读

原标题:首个检索增强3D生成模型!实现各种模态生成大一统:文&图&3D都可以

关键字:模型,视图,研究人员,网络,基础

文章来源:量子位

内容字数:0字

内容摘要:

王振伟 投稿自 凹非寺量子位 | 公众号 QbitAI3D生成也能支持检索增强(RAG)了。

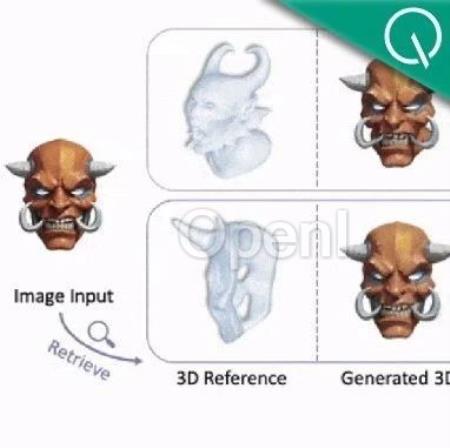

有了检索到的参考模型之后,3D生成效果更好,还具有极强的泛化性和可控性。

比如像这张,它生成几何质量得到了极大的改善。

还可以实现主题一致的3D到3D生成,仅需自参考输入的3D模型即可支持该功能。之前的相关研究需要约1小时,现在压缩不到10秒。

来自香港城市大学、上海人工智能实验室、香港中文大学和南洋理工大学S-Lab的研究人员提出了一种名为Phidias的新3D生成框架。

该框架将语言和图像生成领域中常见的检索增强生成(RAG)引入3D生成。

Phidias是一种参考增强的扩散生成模型。

该模型统一了文生3D、图生3D和3D到3D生成等任务,其利用检索到的或用户提供的3D参考模型来指导3D生成过程,从而提高了生成质量、泛化能力和可控性。

Phidias包含三个关键组件:

1)用于动态调节控制强度的元控制网络(meta-ControlNet);

2)用于减轻输入图像和3D参考模型冲突的动态参考路由模块(dynamic reference routing);

3)用于支持高效自监督学习的自我参考

原文链接:首个检索增强3D生成模型!实现各种模态生成大一统:文&图&3D都可以

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号