AIGC动态欢迎阅读

原标题:微软开源爆火1.58bit大模型推理框架!千亿参数模型量化后单CPU可跑,速度每秒5-7个token

关键字:模型,框架,权重,参数,微软

文章来源:量子位

内容字数:0字

内容摘要:

西风 发自 凹非寺量子位 | 公众号 QbitAI微软开源1bit大模型推理框架!

现在1000亿参数大模型量化后单CPU可跑,速度可达每秒5-7个token。

比如在苹果M2新品上运行BitNet b1.58 3B模型,be like:

就是今年爆火论文The Era of 1-bit LLMs的官方代码实现,开源不到一周GitHub已揽获7.9k Star。

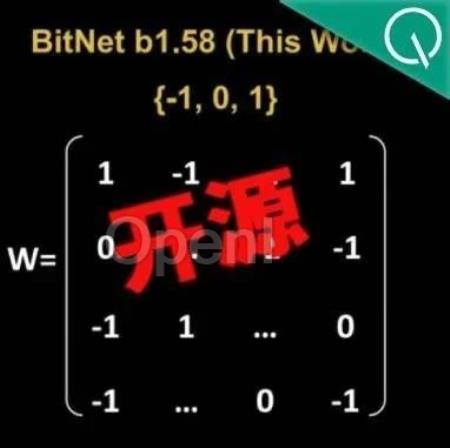

传统大模型参数以16位浮点数(如FP16或BF16)形式的存储,而BitNet b1.58将其统统变成了三进制,也就是{-1, 0, 1}。

这里的“1.58 bit”指每个参数可以用1.58位的信息来表示。

转换之后,矩阵中的计算就只会涉及到加法,因此会让大模型在保持一定精度的同时,显著减少所需的存储空间和计算资源,也显著提升了在本地设备上运行LLM的可能性。

这个项目开源后,在X上也受到了一波高度关注。

千亿参数模型量化后单CPU可跑bitnet.cpp是1bit LLM(例如 BitNet b1.58)的官方推理框架。

该框架配备了一系列优化内核,支持在CPU上进行快速且无损的1.58bit模型推理,未来将扩展支持NPU

原文链接:微软开源爆火1.58bit大模型推理框架!千亿参数模型量化后单CPU可跑,速度每秒5-7个token

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号