AIGC动态欢迎阅读

原标题:清华团队革新MoE架构!像搭积木一样构建大模型,提出新型类脑稀疏模块化架构

关键字:模型,神经元,模块,能力,高效

文章来源:量子位

内容字数:0字

内容摘要:

CFM团队 投稿量子位 | 公众号 QbitAI探索更高效的模型架构, MoE是最具代表性的方向之一。

MoE架构的主要优势是利用稀疏激活的性质,将大模型拆解成若干功能模块,每次计算仅激活其中一小部分,而保持其余模块不被使用,从而大大降低了模型的计算与学习成本,能够在同等计算量的情况下产生性能优势。

然而,此前像MoE等利用稀疏激活性质的研究工作,都认为大模型需要在预训练阶段就额外引入模块化结构约束。

如今,来自清华的一项最新研究打破了以上思维定式,并将MoE架构进行了革新。

具体而言,研究人员受启发于人脑高效的稀疏模块化架构,在论文《Configurable Foundation Models: Building LLMs from a Modular Perspective》中提出了一种类脑高效稀疏模块化架构:Configurable Foundation Model。

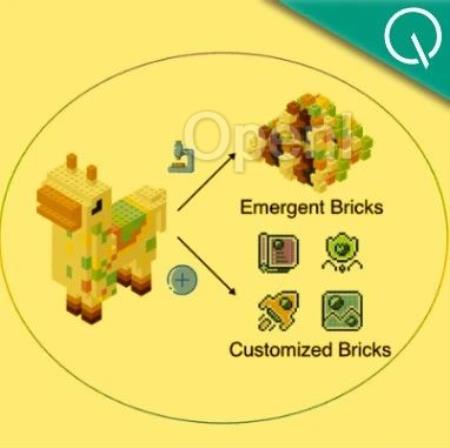

该架构将大模型的模块拆分为预训练阶段产生的涌现模块(Emergent Brick)与后训练阶段产生的定制模块(Customized Brick),然后通过模块的检索、组合、更新与增长可以高效地实现复杂功能配置与组合

原文链接:清华团队革新MoE架构!像搭积木一样构建大模型,提出新型类脑稀疏模块化架构

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号