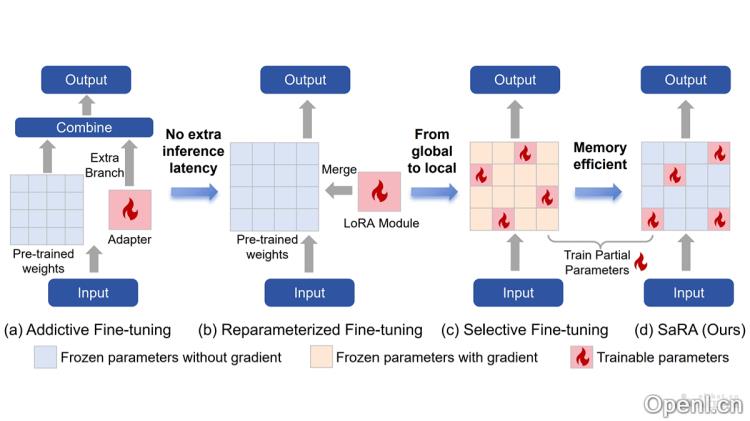

SaRA是一种创新的微调方法,专为预训练扩散模型而设计,由上海交通大学与腾讯优图实验室联合开发。该方法通过重新激活预训练阶段看似无用的参数,使模型能够更好地适应新的任务需求。SaRA采用低秩稀疏训练方案,结合核范数的约束,有效防止过拟合,同时引入渐进式参数调整策略,从而优化模型性能。

SaRA是什么

SaRA是一种新颖的预训练扩散模型微调方法,由上海交通大学与腾讯优图实验室共同研发。其核心理念是重新激活那些在预训练过程中未被充分利用的参数,使得模型能够灵活适应新的任务。SaRA通过核范数低秩稀疏训练方案来避免模型在微调过程中的过拟合,并引入渐进式参数调整策略,从而显著提升模型性能。该方法不仅提高了模型的适应性和泛化能力,还显著降低了计算成本,用户只需简单修改一行代码便可实现,具有极高的实用价值。

SaRA的主要功能

- 参数重新利用:激活在预训练中未得到有效利用的参数,为模型赋予新的能力。

- 防止过拟合:通过核范数低秩稀疏训练策略,减少微调过程中的过拟合现象。

- 渐进式参数调整:在微调过程中持续评估和选择参数,确保所有潜在有效的参数充分利用。

- 非结构化反向传播:降低微调过程中的内存成本,增强参数选择的灵活性。

- 提升模型性能:在保留预训练模型原有知识的同时,优化模型在主要任务上的表现。

SaRA的技术原理

- 参数重要性分析:分析预训练模型中的参数,识别出在生成过程中影响较小的参数。

- 低秩稀疏训练:对参数施加低秩约束,基于优化稀疏权重矩阵来学习任务特定的知识,从而提高微调效率,减少过拟合。

- 渐进式参数调整策略:设计动态调整参数的策略,确保在微调过程中充分利用所有潜在有效的参数。

- 非结构化反向传播:通过特殊的反向传播策略,减少微调过程中的内存消耗,增强模型对特定任务的适应性。

- 模型兼容性:SaRA方法与现有预训练模型兼容,用户只需少量代码修改即可实现微调,便于集成到现有系统中。

SaRA的项目地址

- 项目官网:sjtuplayer.github.io/projects/SaRA

- GitHub仓库:https://github.com/sjtuplayer/SaRA

- arXiv技术论文:https://export.arxiv.org/pdf/2409.06633

SaRA的应用场景

- 图像风格迁移:利用SaRA调整模型参数,将普通图像转化为具有特定艺术风格的作品,如油画或素描风格,同时保持内容和结构的完整性。

- 图像定制化:在Dreambooth等应用中,通过SaRA对UNet网络进行微调,实现特定对象或风格的图像定制化,生成符合特定特征的图像。

- 视频生成:SaRA可用于微调视频生成模型(如AnimateDiff),在不同摄像机(如缩放、平移)的数据集上进行微调,生成具有特定动态效果的视频。

- 下游数据集微调:SaRA可在各种下游数据集上进行微调,以适应不同的领域特定任务,例如在不同风格的数据集上进行微调,以生成与文本提示一致的图像。

- 图像生成任务:SaRA通过优化最初未有效利用的参数,提升预训练模型在图像生成任务中的性能。

常见问题

- SaRA需要多少计算资源?:SaRA在计算资源上非常高效,能够显著降低微调所需的计算成本。

- 我如何开始使用SaRA?:用户只需根据项目官网提供的说明进行简单的代码修改,即可快速上手使用SaRA。

- SaRA与其他微调方法有何不同?:SaRA通过重新激活未充分利用的参数,并结合低秩稀疏训练策略,显著提升了模型性能和泛化能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号