Self-Taught Evaluators是一种创新的模型评估方法,旨在通过自我训练机制提升大型语言模型(LLM)的评估能力,完全不依赖人工标注数据。该方法从未标记的指令出发,利用迭代自我改进的流程生成对比模型输出,并通过LLM作为裁判,形成推理轨迹与最终判断。实验表明,Self-Taught Evaluators显著提高了基于Llama3-70B-Instruct模型的评估准确率,从75.4提升至88.3,并在多数投票情况下达到了88.7,超越了常用的LLM裁判如GPT-4,其表现可与人工标注数据训练的顶级奖励模型相媲美。

Self-Taught Evaluators是什么

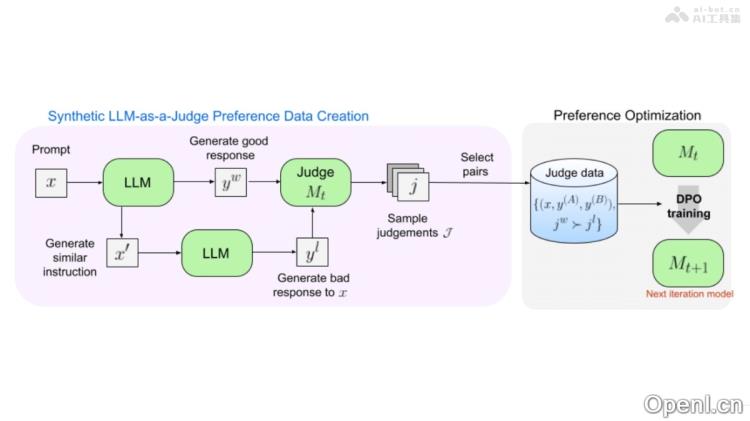

Self-Taught Evaluators是一种前沿的模型评估技术,旨在利用自我训练的方式提升大型语言模型(LLM)的评估精度,而无需依赖人工标注的数据。该方法从未标记的指令开始,采用迭代的自我改进策略生成对比模型的输出。通过使用LLM作为评判者,该方法能够生成详细的推理轨迹和最终判断,确保模型的持续优化。

Self-Taught Evaluators的主要功能

- 生成对比模型输出:从未标记的指令出发,基于提示生成不同质量的模型响应对。

- 训练LLM作为裁判:利用LLM生成推理过程和最终判断,以评估不同响应的优劣。

- 迭代自我改进:每次迭代中,通过当前模型的判断生成训练数据,微调模型,实现自我优化。

- 评估模型性能:在标准评估协议,例如RewardBench上评估模型的准确性,并与人类评估结果进行对比。

Self-Taught Evaluators的技术原理

- 初始化:假设能够访问大量人类编写的用户指令和一个初步的种子LLM。

- 指令选择:基于LLM对指令进行分类,选择具有挑战性和平衡分布的指令子集。

- 响应对构建:为每个选定的指令生成偏好数据,包括两个响应(优选和非优选),确保非优选响应的质量低于优选响应。

- 迭代训练:包括判断注释和模型微调两个步骤,当前模型生成推理过程和判断,正确判断的示例将被添加到训练集中,以便微调模型,为下一次迭代提供更新的版本。

Self-Taught Evaluators的项目地址

- GitHub仓库:https://github.com/facebookresearch/RAM/tree/main/projects/self_taught_evaluator

- HuggingFace模型库:https://huggingface.co/datasets/facebook/Self-taught-evaluator-DPO-data

- arXiv技术论文:https://arxiv.org/pdf/2408.02666

Self-Taught Evaluators的应用场景

- 语言模型开发:在研发新型大型语言模型时,Self-Taught Evaluators能够有效评估和优化模型输出的质量,确保生成的文本符合预期标准。

- 自动化内容评估:在内容创作领域,如新闻机构、出版业或社交媒体平台中,用于自动化评估内容的质量和准确性,提高内容审核的效率。

- 教育和学术研究:在教育行业,Self-Taught Evaluators可以作为辅助工具,帮助评估学生的写作作业或研究论文,并提供反馈和改进建议。

- 客服和技术支持:在客户服务领域,用于评估自动回复系统的质量,确保回复既准确又有帮助,从而提升客户满意度。

- 编程和代码生成:在需要代码生成和评估的场景中,Self-Taught Evaluators能够有效评估生成的代码片段的质量,帮助开发人员进行改进。

常见问题

- Self-Taught Evaluators的优势是什么?该方法的主要优势在于无需人工标注数据,通过自我训练和迭代改进,可以持续提升模型的评估能力。

- 如何开始使用Self-Taught Evaluators?您可以访问其GitHub仓库或HuggingFace模型库获取相关资料和代码,按照说明进行配置和使用。

- Self-Taught Evaluators适用于哪些类型的项目?该方法广泛适用于语言模型开发、自动化内容评估、教育评估、客服支持以及编程相关的应用场景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号