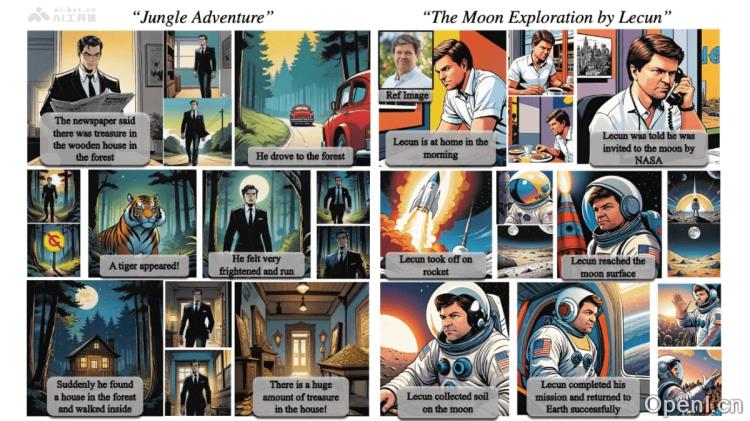

StoryDiffusion是一款前沿的AI图像与视频生成框架,能够根据文本描述创造出具有高度一致性的图像与视频序列。通过Consistent Self-Attention机制,StoryDiffusion确保生成的内容在角色及服饰等方面保持连贯性。此外,该平台引入了语义预测模块,能够在语义层面预测图像之间的变化,从而生成流畅且一致的视频效果。StoryDiffusion为用户提供了将文本故事转化为视觉内容的强大工具,包括漫画和视频形式,极大地增强了用户通过文本提示控制生成内容的能力。这一创新推动了视觉故事生成领域的研究,开启了全新的创作可能性。

StoryDiffusion是什么

StoryDiffusion是一款先进的AI图像与视频生成框架,旨在根据文本描述生成一致性的图像及视频序列。利用Consistent Self-Attention机制,该框架增强了图像间的一致性,确保生成内容在身份与服饰等细节上保持连贯。通过引入语义预测器模块,StoryDiffusion能够在语义空间内预测图像之间的变化,从而生成平滑且连贯的视频。此技术可将文本故事转化为视觉内容,支持漫画和视频形式,提升用户的内容生成控制能力,为视觉故事创作提供了新的可能性。

StoryDiffusion的主要功能

- 一致性图像生成:根据文本描述生成内容一致的图像,适用于叙事与故事讲述。

- 长视频生成:将图像转换为具备平滑过渡和一致主体的视频。

- 文本驱动的内容控制:支持用户通过文本提示来控制生成的图像和视频内容。

- 即插即用模块集成:Consistent Self-Attention模块无需训练即可直接集成到现有图像生成模型中。

- 滑动窗口支持长故事:通过滑动窗口机制,支持长文本故事的图像生成,不受输入长度限制。

StoryDiffusion的技术原理

- 一致性自注意力(Consistent Self-Attention):在自注意力计算中引入跨图像的token,增强不同图像之间的一致性。

- 语义预测器(Semantic Motion Predictor):将图像映射到语义空间,预测中间帧的条件。

- Transformer结构预测:在语义空间中利用Transformer结构预测一系列中间帧。

- 视频扩散模型:将预测得到的语义空间向量作为控制信号,基于视频扩散模型解码最终的视频帧。

- 无需训练的即插即用:Consistent Self-Attention模块重用现有的自注意力权重,无需额外训练。

StoryDiffusion的项目地址

- 项目官网:storydiffusion.github.io

- GitHub仓库:https://github.com/HVision-NKU/StoryDiffusion

- arXiv技术论文:https://arxiv.org/pdf/2405.01434

StoryDiffusion的应用场景

- 动漫和漫画创作:艺术家与作家能够将文本故事转化为视觉漫画或动漫,提升创作效率。

- 教育与故事讲述:在教育领域中,生成故事书或教材插图,帮助学生更好地理解故事内容。

- 社交媒体内容制作:内容创作者可生成吸引人的图像和视频,提升社交媒体平台的用户互动。

- 广告与营销:营销人员能够快速生成引人注目的广告视觉内容,增强广告吸引力。

- 电影与游戏制作:在电影预览、游戏设计等领域,生成概念艺术或故事板。

- 虚拟主播与视频会议:生成虚拟形象和动态背景,用于直播、视频会议或在线教育。

常见问题

- StoryDiffusion适合哪些用户?:无论是艺术家、教育工作者还是内容创作者,StoryDiffusion都能为他们提供极大的帮助。

- 使用StoryDiffusion需要专业知识吗?:不需要,用户只需通过文本描述即可生成图像和视频,操作简单。

- 生成的内容质量如何?:得益于先进的技术,生成的图像和视频具有高一致性和细节表现。

- StoryDiffusion是否支持多种语言?:目前主要支持英文文本描述,未来会扩展到其他语言。

- 如何获取更多信息?:用户可以访问项目官网或GitHub仓库,获取详细文档和更新信息。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号