ImageBind是Meta公司推出的一款开源多模态AI模型,能够将文本、音频、图像、温度和等六种不同类型的信息整合到一个统一的嵌入空间中。该模型利用图像模态作为桥梁,巧妙地实现了其他模态数据的隐式对齐,且无需直接的模态间配对数据。ImageBind在跨模态检索和零样本分类等任务中展现了出色的性能,为创造沉浸式的多感官AI体验开辟了全新的可能性。

ImageBind是什么

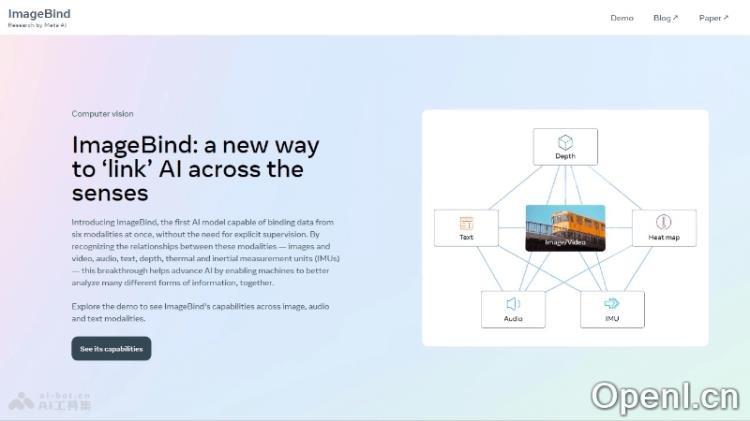

ImageBind是由Meta公司发布的开源多模态AI模型,旨在将不同类型的数据(如文本、音频、视觉、深度信息、热成像和IMU数据)整合到一个统一的嵌入空间中。该模型通过图像模态作为媒介,能够实现其他模态的数据隐式对齐,无需依赖直接的模态配对数据。ImageBind在多种任务中表现出色,推动了沉浸式、多感官AI体验的实现。

主要功能

- 多模态数据整合:将六种不同模态的数据(图像、文本、音频、深度信息、热成像和IMU数据)汇聚到一个统一的嵌入空间中。

- 跨模态检索:借助联合嵌入空间,实现不同模态之间的信息检索,例如,通过文本描述找到相关的图像或音频内容。

- 零样本学习:在没有明确监督的情况下,模型能学习新的模态或任务,尤其在样本稀缺的情况下展现出独特优势。

- 模态对齐:利用图像模态,将其他模态的数据进行隐式对齐,使不同模态的信息能够相互理解和转换。

- 生成任务:ImageBind可用于生成任务,例如,根据文本描述生成相应的图像,或根据音频生成视觉内容。

技术原理

- 多模态联合嵌入:ImageBind通过训练模型学习联合嵌入空间,将不同模态的数据(图像、文本、音频等)映射到同一向量空间,使其信息能够相互关联和比较。

- 模态对齐:以图像作为核心,将其他模态的数据与图像数据对齐,即使缺乏直接配对数据,也能通过与图像的关联实现有效对齐。

- 自监督学习:该模型采用自监督学习方法,依赖数据本身的结构和模式,而不需要大量人工标注。

- 对比学习:对比学习是ImageBind中的关键技术之一,通过优化正样本对的相似度和负样本对的不相似度,模型能够学习区分不同数据样本的特征。

项目地址

- 项目官网:imagebind.metademolab.com

- GitHub仓库:https://github.com/facebookresearch/ImageBind

- arXiv技术论文:https://arxiv.org/pdf/2305.05665

应用场景

- 增强现实(AR)和虚拟现实(VR):在虚拟环境中,ImageBind可以生成与用户互动的多感官体验,例如根据用户的动作或语音指令生成相应的视觉和音频反馈。

- 内容推荐系统:通过分析用户的多模态行为数据(如视频观看时的语音评论、文本评论和观看时长),ImageBind能够提供更个性化的内容推荐。

- 自动标注和元数据生成:为图像、视频和音频内容自动生成描述性标签,以便更好地组织和检索多媒体资源。

- 辅助技术:为视觉或听力障碍人士提供帮助,例如将图像内容转换为音频描述,或将音频内容转化为可视化表示。

- 语言学习应用:结合文本、音频和图像,帮助用户在语言学习过程中获得更丰富的上下文信息。

常见问题

- ImageBind的主要优势是什么?:ImageBind通过整合多种模态的数据,能够提供更丰富和多样的AI体验,尤其在缺乏标注数据的情况下表现出色。

- 如何使用ImageBind?:用户可以通过访问项目官网或GitHub仓库获取文档和示例,按照指南进行模型的训练和应用。

- ImageBind适用于哪些领域?:该模型广泛适用于增强现实、内容推荐、自动标注、辅助技术以及语言学习等多个领域。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号