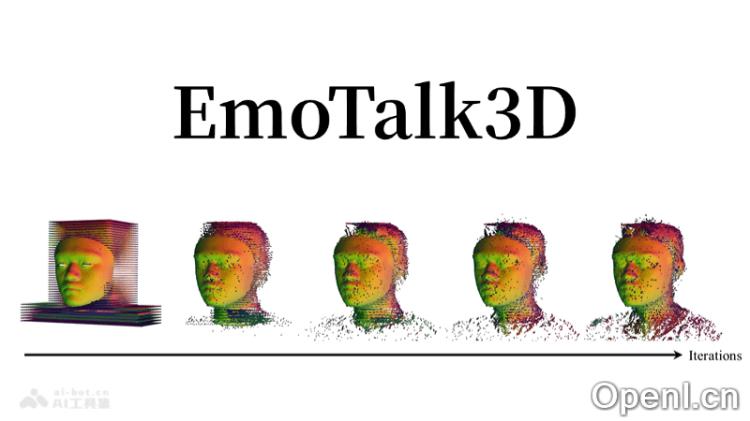

EmoTalk3D是一款由华为诺亚方舟实验室、学和复旦大合开发的3D数字人框架。其核心技术在于合成具有丰富情感表达的3D会说话头像,能够精准捕捉和重现人类说话时的唇部动作、面部表情,甚至是细微的情感变化,如皱纹和其他面部微动。

EmoTalk3D是什么

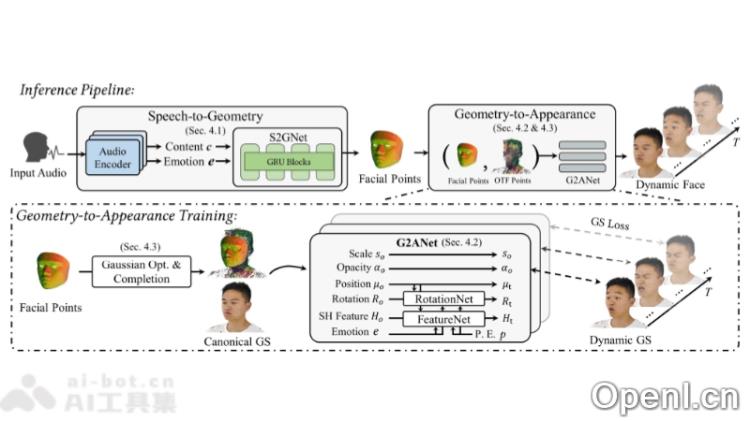

EmoTalk3D是由华为诺亚方舟实验室、学与复旦大学共同推出的一种3D数字人框架。它的核心在于生成具有丰富情感的3D会说话头像。EmoTalk3D能够捕捉并重现人类在说话时的唇部、面部表情,甚至是更细微的情感细节,如皱纹和其他面部微小动作。通过“Speech-to-Geometry-to-Appearance”映射框架,该技术实现了从音频特征到3D几何序列的预测,最终合成3D头像的外观。

EmoTalk3D的主要功能

- 情感表达合成:根据输入的音频信号生成相应情感的3D头像动画,包括喜悦、悲伤、愤怒等多种情感状态。

- 唇部同步:确保3D头像在发声时,唇部与实际发音高度一致。

- 多视角渲染:支持从不同视角查看3D头像,保持高质量和一致性。

- 动态细节捕捉:再现说话时的微表情和动态细节,如皱纹和细微表情变化。

- 可控情感渲染:用户可以实时调整3D头像的情感表达,满足不同需求。

- 高保真度:采用先进渲染技术,生成高分辨率、极具真实感的3D头像。

EmoTalk3D的技术原理

- 数据集建立(EmoTalk3D Dataset):收集了多视角视频数据,包括情感标注及每帧的3D面部几何信息,数据来源于多个受试者在不同情感状态下录制的多视角视频。

- 音频特征提取:使用预训练的HuBERT模型作为音频编码器,将输入语音转换为音频特征,提取情感标签。

- Speech-to-Geometry Network (S2GNet):输入音频特征和情感标签,预测动态3D点云序列,基于门控循环单元(GRU)架构生成4D网格序列。

- 3D几何到外观的映射(Geometry-to-Appearance):基于4D点云,使用Geometry-to-Appearance Network (G2ANet)合成3D头像的外观,将外观分解为规范高斯(静态外观)和动态高斯(由面部引起的皱纹、阴影等)。

- 4D高斯模型:采用3D高斯Splatting技术表示3D头像外观,每个3D高斯由位置、尺度、旋转和透明度参数化表示。

- 动态细节合成:通过FeatureNet和RotationNet网络预测动态细节,如皱纹和微表情变化。

- 头部完整性:对非面部区域(如头发、颈部和肩部),使用优化算法从均匀分布的点构建。

- 渲染模块:融合动态高斯和规范高斯,渲染出视角的3D头像动画。

- 情感控制:通过人工设置情感标签和时间序列变化,控制生成头像的情感表达。

EmoTalk3D的项目地址

EmoTalk3D的应用场景

- 虚拟助手和客服:可以作为智能客服或虚拟助手,提供更加自然和情感丰富的互动体验。

- 电影和视频制作:在电影、电视和视频游戏中生成逼真的角色和动画,提升视觉体验。

- 虚拟现实(VR)和增强现实(AR):在VR和AR应用中提供沉浸式体验,与用户进行更加真实的互动。

- 社交媒体和直播:用户可以利用EmoTalk3D创建和自定义自己的3D形象,在社交媒体平台或直播中展示。

- 广告和市场营销:创建吸引人的3D角色,应用于广告宣传或品牌推广。

常见问题

EmoTalk3D是否可以用于商业用途?

是的,EmoTalk3D的应用场景广泛,可以用于商业广告、虚拟助手等多个领域。

如何获取EmoTalk3D?

您可以访问其官方网站,获取更多信息和下载相关资源。

EmoTalk3D支持哪些平台?

EmoTalk3D可以在多种平台上使用,具体支持情况请参考官方网站的说明。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号